Meinung

Widerrede im Kampf gegen Hassbotschaften ist substanziell - sie sollte aber von echten Menschen kommen. © picture alliance / dpa / Christoph Schmidt

Hatespeech und Fake News: KI ist nicht die Lösung

Beim Kampf gegen Fake News und Hassbotschaften im Netz könnte Künstliche Intelligenz helfen. Doch der Literatur- und Medienwissenschaftler Roberto Simanowski hält das für keine gute Idee.

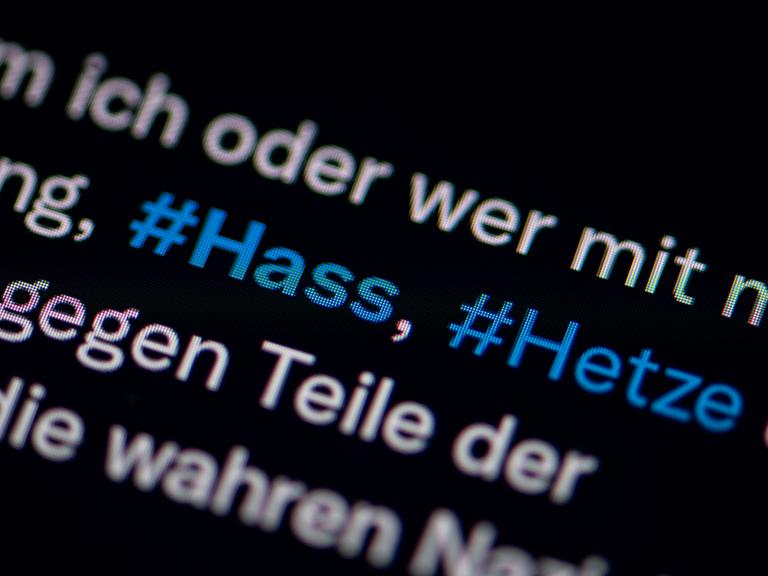

Das Internet ist vergiftet. Das ist allgemein bekannt. Es gibt Fake News, Hatespeech, Rassismus, Sexismus. Was kann man tun? Man kann solche Inhalte herausfiltern. Oder: Man kann ihnen widersprechen.

Ein Beispiel dafür ist die 2016 gegründete Counter-Speech-Initiative #Ichbinhier. Deren Mitglieder gehen auf Facebook gezielt in Kommentarspalten hinein, um beleidigende Äußerungen zurückzuweisen und Falschaussagen zu widersprechen. Dann liken sie gegenseitig ihre Posts und sorgen so dafür, dass die kleine, aber laute Gruppe der Giftmischer weniger sicht- und hörbar ist.

Widerspruch ist besser als löschen

Das ist mühsam - und überall können die #Ichbinhier-Aktivisten ja auch nicht sein. Insofern schlagen andere vor, das Problem mit einer KI zu lösen, die viel effizienter auf aggressive Posts reagieren könnte. Inzwischen gibt es auch eine Reihe von Studien, wie sich Gegen-Narrative zu Hassreden in sozialen Netzwerken automatisieren lassen.

Ein Argument, das dabei zentral ist: Die Produktion von Gegen-Narrativen verhindere die Gefahr der übermäßigen Zensur von Inhalten durch die Plattformbetreiber, wenn diese toxische Inhalte einfach löschen. Das stimmt natürlich: Widerspruch ist immer besser als Canceln. Und insofern mag der Ansatz einer KI-basierten Produktion von Gegengift doppelt plausibel klingen.

Die Trolle mit den eigenen Waffen schlagen

Er ist trotzdem höchst problematisch. Bei einer Initiative wie den #Ichbinhier-Aktivisten treffen Trolle auf ihre Widersacher. Das ist ein fairer Kampf unter Gegnern wie einst auf dem Schlachtfeld. Ein Kampf, der ein gesellschaftliches Verhältnis repräsentiert. Ein Kampf, bei dem Menschen aus der Zivilgesellschaft den Hass-Predigern klar machen, dass sie nicht in der Mehrheit sind.

Anders verhält es sich, wenn eine KI den Einspruch vieler suggeriert. Dann wird die Existenz vieler besorgter und aufgebrachter Bürger vorgetäuscht, während in Wahrheit all diese Äußerungen nur von einer KI stammen.

"Na und?" mögen die Fans einer KI-basierten Produktion von Gegengift entgegnen. Wer sagt denn, dass hinter den Hass-Reden nicht auch nur ein einziger Chatbot steht, der am Fließband toxische Inhalte produziert? Warum sollte man das Böse nicht mit seinen eigenen Waffen schlagen?

"Gute" gegen "schlechte" Bots

Die Versuchung ist natürlich groß, mit technischen Mitteln soziale Probleme zu lösen. Und dieser Solutionismus, wie das Fachwort dafür heißt, ist definitiv ein Lieblingsgedanke in der IT-Branche. Aber es hieße eben auch, zwischenmenschliche Kommunikation gezielt mit künstlichen Akteuren zu durchsetzen, die sich nicht als solche zu erkennen geben. Das mag kurzfristig den Guten gegen die Bösen Auftrieb geben. Langfristig ist dieser Ansatz eine Sackgasse.

Zum einen würde es zu einem Wettrüsten der „guten“ und „bösen“ Bots führen. Nachdem sich die Menschen in sozialen Netzwerken schon jetzt kaum noch geduldig zuhören, würde man dann nicht einmal mehr einen Grund haben, den Widerspruch seines Gegenübers zu registrieren, wenn man annehmen muss, dass man es mit einer KI zu tun hat. So wie Falschgeld dem Finanzsystem schadet, würde das kommunikative Falschgeld der KI den politischen Meinungsbildungsprozess der Gesellschaft schädigen.

Computergeneriertes Gegengift ist selbst toxisch

Zum anderen würde es perspektivisch dazu führen, dass die Aktivisten der Zivilgesellschaft gar nicht mehr selbst aktiv werden müssten, wenn die KI den Job übernimmt. Und wenn sie sich nicht mehr selbst engagieren müssen, erfahren sie sich auch nicht mehr als engagierte Bürger.

Sie würden den Einspruch ebenso der KI überlassen wie das Schreiben von Texten, das einem nun ChatGPT abnimmt, oder die Orientierung im Raum, die man längst ans Navi delegiert hat. Die KI mag effizienter das erreichen, was Menschen wollen, zerstört dabei aber auch den Willen der Menschen.

Insofern ist die Delegation des Widerspruchs gegen toxische Inhalte an eine KI nicht die Fortführung einer persönlichen Anstrengung mit technischen Mitteln. Vielmehr ist der Wechsel vom handgemachten zum computergenerierten Gegengift auf seine Weise selbst toxisch.