Wie die Digitalisierung die Wissenschaft verändert

Schon in den 40er-Jahren wurde ein Rechner für die geisteswissenschaftliche Arbeit genutzt. Mehr als 70 Jahre später werden von der Linguistik über die Archäologie bis hin zur Theologie digitalisierte Quellen mit Computern ausgewertet. Aber wie verändert das die Forschung?

Die Abtei St. Matthias in Trier. Schon seit dem 4. Jahrhundert nach Christus leben hier Mönche zusammen. 977 nahm der Orden die Benediktinerregel an.

"Die Benediktiner sind eine sehr buch- und bibliotheksfixierter Orden, der eine Bibliothek haben musste."

Philipp Vanscheidt, Literaturwissenschaftler. Am Centre for Digital Humanities an der Universität Trier hat er in einem Forschungsprojekt zusammen mit Kollegen die Bibliothek des Klosters digital rekonstruiert. Denn die Handschriften liegen schon lange nicht mehr nur in Trier.

"Das heißt, wir haben alle Dokumente, deren wir habhaft werden konnten, digitalisiert und mit beschreibenden Katalogdaten versehen, die wir aus älteren Katalogen zusammengetragen haben. Und dadurch insgesamt etwa 470 Codices zusammengeführt, die heute auf 25 Orte weltweit verstreut liegen."

Dank digitaler Technik ist die Bibliothek für Interessierte nun wieder als Ganzes zugänglich. Als sogenanntes "Virtuelles Skriptorium" im Internet. Auf analogem Weg wäre das nicht möglich gewesen.

"Also es gibt einige Kodizes, die heute in New York und Berkeley liegen, die natürlich nicht transportiert wurden aus Versicherungsgründen, weil die Kosten viel zu hoch gewesen wären, die aber jetzt auch über unsere Datenbank verfügbar sind. Das heißt man kann jetzt einen relativ gute Gesamtüberblick darüber bekommen, wie dieses Skriptorium tatsächlich ausgesehen hat, welchen Bestand es gab an Handschriften aus dem vom 8.-16. Jahrhundert."

Darüber hinaus arbeiten Forscher verschiedener Universitäten gemeinsam an einem weiteren Forschungsprojekt...

"...wo wir die Bestände von Sankt Matthias nutzen, um Algorithmen zu erstellen, um diese Bestände automatisch zu durchforsten, um dann das Layout, die Kennzeichen dieser hunderte von Handschriften zu untersuchen. Das können wir nur digital machen."

Claudine Moulin, Professorin für Altgermanistik an der Universität Trier. Sie leitet das Center for Digital Humanities. Welche Fragen wollen die Wissenschaftler mit digitalen Methoden beantworten?

"Wie groß sind die Pergamentkodizes, wie sieht die Spaltengestaltung aus? Wie viel Rand gibt es, wie sehen die Zeilenabstände aus, wie sieht die Handschrift aus? Können wir Handschriftenmerkmale automatisch erkennen? Das sind alles Spuren der Entstehung dieser Handschriften, die sehr wichtig sind und die wir mit sozusagen einem automatischen Tagging, mit Algorithmen, mit Programmen sichtbar machen können, um zum Beispiel Kontinuitäten, Traditionen in einer Schreibstube oder an einem Ort, in einem bestimmten Skriptorium im Mittelalter heraus zu arbeiten.

In einer Nussschale kann man sagen, dass die Digital Humanities einen Zugang zu geisteswissenschaftlicher Forschung ermöglichen, anhand von digitalen Methoden. In den Naturwissenschaften mag dies schon eine längere Tradition haben, in den Geisteswissenschaften öffnen sich hier erst die Perspektiven."

Digitalisierung macht auch vor Geisteswissenschaften nicht halt

Die Digitalisierung hat in den vergangenen Jahrzehnten immer mehr Gesellschaftsbereiche erfasst und verändert. Auch vor den Geisteswissenschaften macht sie nicht halt. "Digital Humanities" – ein fächerübergreifender Trend.

"Es geht um die Entwicklung von Fragestellungen, von Methoden, von Tools, mit denen ich neue Fragen an geisteswissenschaftlichen Quellenmaterial oder geisteswissenschaftliche Konstrukte anwenden kann, um eben auch Neues zu erforschen, neue Zusammenhänge zu erstellen."

Immer wieder taucht dabei auch ein Begriff auf, der Debatten über Digitalisierung wie kein anderer prägt: "Big Data". Gemeint sind Analysemethoden, mit denen leistungsstarke Computer unüberschaubar riesige Datenmengen durchsuchen können. Verfahren, wie man sie in den Naturwissenschaften oder der Soziologie vermuten würde. Aber in der Literaturwissenschaft?

"Man hat dann mehr Daten über mehr Texte, kann natürlich viel mehr Texte einbeziehen, als man lesen kann und kann mehr Aussagen treffen, zum Auftreten bestimmter Begriffe zu bestimmten Zeiten."

Roberto Simanowski, Literatur- und Medienwissenschaftler.

"Aber das ist kein Interpretationsgeschäft, was dann passiert, das sind statistische Werte, die produziert werden und das ist eine andere Literaturwissenschaft als die der Interpretation."

Simanowski hat eine Professur für Digital Media Studies und Digital Humanities an der City University of Hong Kong. Er betrachtet die neue Entwicklung in den Geisteswissenschaften neugierig, aber kritisch. Dass statistisch geprägte Analysen sich immer weiter ausbreiten, könne dazu führen...

"...dass diese Leute dann das Geschäft der Literaturwissenschaft bestimmen. Und das wäre eben keine Liebe mehr zum Text, sondern eher zur Zahl."

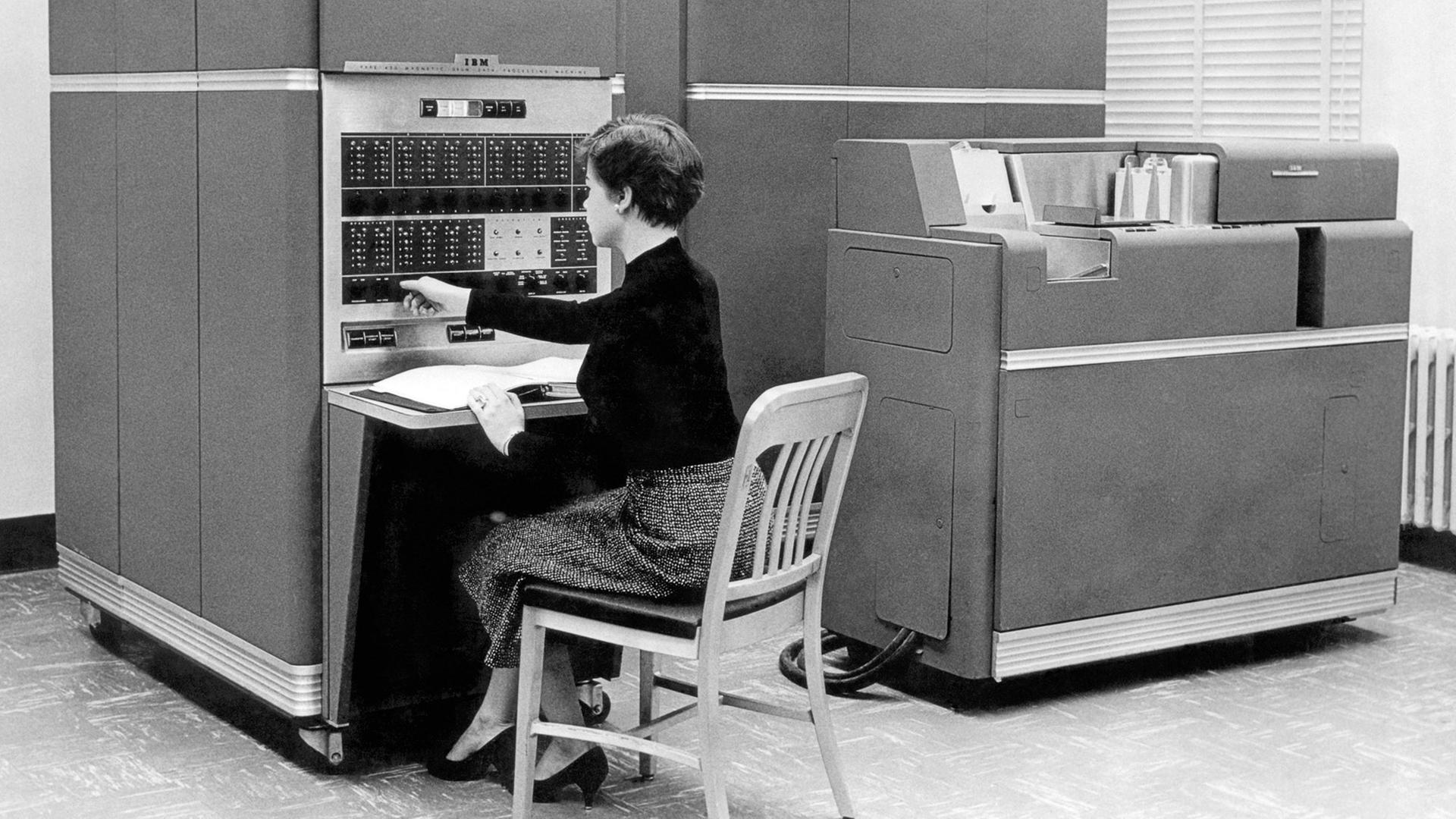

Zu Beginn des Computerzeitalters

So ganz neu ist diese Liebe zur Zahl in den Geisteswissenschaften allerdings nicht. Schon zu Beginn des Computerzeitalters kamen entsprechende Verfahren zum Einsatz. Es war der Jesuit, Theologe und Linguist Roberto Busa, der in den 40er-Jahren zum ersten Mal einen Rechner für die geisteswissenschaftliche Arbeit nutzte.

"Und Roberto Busa hat, und deswegen gilt er auch eigentlich als Gründungsvater der Digital Humanities, den sogenannten ´Index Thomasticus` erstellt. Also einen Index zu den Schriften von Thomas Aquin."

Vierzig Jahre, so hatte man ursprünglich veranschlagt, würde diese Aufgabe in Anspruch nehmen. Busa arbeitete mit James Watson, dem Gründer von IBM zusammen. Und schaffte es stattdessen in sieben Jahren. Ein 56-bändiges Werk von insgesamt rund 70.000 Seiten.

Er hat das noch mit ganz für uns heute komplizierten Verfahren mit Lochkarten und alles gemacht. Also eine Unmenge an Texten, hier theologisches Schrifttum, so durchsuchbar zu machen, dass man nicht mehr an der sozusagen logischen Reihenfolge der Seiten gebunden ist, sondern diese Texte dann auch unter frei zugänglichen Gesichtspunkten anderer kombinatorischer Möglichkeiten eben durchsuchen kann.

Busas Pionierarbeit wurde wegweisend für die digital gestützte Analyse von Sprache, die in Disziplinen wie der Computerlinguistik ab den 1970er-Jahren an den Universitäten Fuß fasste. In den Geisteswissenschaften fremdelte man anfangs mit der neuen Forschungsrichtung. Inzwischen ist das anders.

Digital Humanities ist das neue Buzzword in den Humanities. Ich würde sagen, seit den letzten fünf Jahren ist es sehr breitenwirksam geworden. So breitenwirksam, dass es keine großen Konferenzen der Geisteswissenschaften mehr gibt, ohne irgendein Panel dazu.

Sich für den digitalen Wandel stärker öffnen

Das sieht Anne Baillot etwas anders. Die Germanistin lehrt und forscht an der Humboldt-Universität Berlin. Und findet, dass die Geisteswissenschaften sich für den digitalen Wandel stärker öffnen müssten.

"Wobei man natürlich nicht davon ausgehen kann, dass alle Geisteswissenschaftler von heute auf morgen plötzlich computergestützte Methoden anwenden werden, das ist auch nicht der Sinn der Sache. Was ich meine, ist, dass die Fächer diese Entwicklung für sich reflektieren sollten und das machen auch einige Fächer bereits, zum Beispiel in der Archäologie…"

...in der Germanistik dagegen hinke man noch sehr hinterher.

"...jetzt in meinem Fachbereich, der Neueren Deutschen Literatur – ich wundere mich immer, wie wenig digital gearbeitet wird, grundsätzlich."

Dabei gäbe es so viele Gelegenheiten dazu. Anne Baillot hatte im vergangenen Semester eine fächerübergreifende Professur für Digital Humanities an der Universität Stuttgart inne.

"Wenn ich jetzt von meinen Lehrveranstaltungen ausgehe: Bei den Germanisten gebe ich einen Kurs digital edieren. Also wie bereite ich Corpora so auf, dass ich dann eine vernünftige wissenschaftliche digitale Edition aufbaue. Bei den Anglisten biete ich einen Kurs an zu Wikipedia, wie entsteht Wissen bei Wikipedia, wie kann man das benutzen, wie kann man das mit begleiten, selber bei Wikipedia schreiben. Wie kann man kritisch Wikipedia benutzen, das ist im akademischen Betrieb immer so eine schwierige Frage, was macht man mit Wikipedia. Bei den Historikern habe ich einen Kurs über historische Netzwerke, wie man die digital aufbereiten kann."

Solche Netzwerke spielen auch in Baillots eigener Forschung eine Rolle.

"Das ist eine Edition von Briefen und Texten Berliner Intellektueller aus der Zeit um 1800. Da sind wir ins Archiv gegangen und haben nach Handschriften gesucht, die bisher nicht ediert wurden oder in der Form nicht ediert wurden und mit der Idee, wir können diese unterschiedlichen Texte und Briefe miteinander verbinden, um zu neuen Erkenntnissen zu kommen? Und es war unser Versuch, uns ein bisschen vom Autorenbegriff loszulösen, wie er seit dem 19. Jahrhundert immer wieder in den Mittelpunkt gestellt wurde."

Vernetzung und Kommunikation wird sichtbar

In digitalen Editionen können verschiedene Dokumente miteinander verknüpft werden. Dadurch wird auch die Vernetzung und Kommunikation der jeweiligen Akteure sichtbar.

Jetzt wollen wir diese Netzwerke visualisieren und mit der Edition selbst verknüpfen, dass Sie dann die Möglichkeit haben, zu sehen: In dem einen Jahr waren der und der Autor in Kontakt. Und dann können Sie nach dem Brief suchen und vielleicht in dem Brief die Erwähnung des einen oder anderen Werkes finden, das der Sprecher damals geschrieben hat. Und dann können Sie auch sehen, wie der Briefpartner dazu beigetragen hat, dass der Schluss so oder so ausgefallen ist.

Im Gegensatz zu einer gewöhnlichen Edition in Papierform sind die digitalen Pendants im Netz außerdem dynamisch und veränderbar.

"Man hat die Möglichkeit, auch Dinge hinzuzufügen, zu verbessern und den Text anzureichern. Das ist nicht ganz unproblematisch, weil es bedeutet, dass man so eine Webseite mit Angabe des Datums immer nur zitieren kann, weil immer die Möglichkeit gegeben ist, dass am nächsten Tag eine Veränderung durchgeführt wird. Und das ist beispielsweise ein Problem für die traditionelle Editionswelt, weil die Zitierfähigkeit einfach als unzureichend betrachtet wird."

Das Beispiel verdeutlicht eines der wichtigsten Problemfelder der neuen Forschungsrichtung aus Sicht von Anne Baillot. Die Frage nach einheitlichen Standards und dadurch möglicher Qualitätssicherung. Denn nicht nur die Digitalisate ursprünglich analoger Quellen wollen berücksichtigt werden. Sondern auch die von vornherein digitalen, zum Beispiel Texte im Internet.

"Und für diese Art von Quellen haben wir noch keine Standards. Wir wissen, was die Standards zum Beispiel einer Edition sind, weil diese Standards gibt es schon lange, die sind etabliert worden durch eine lange Geschichte. Bei digitalen Quellen ist immer noch nicht wirklich klar, was der Standard ist."

Digital Humanities und Blogs

Wie sieht es zum Beispiel mit Blogs aus?

"Man kann nicht sagen, wenn ich auf einen Blog verweise, das ist eine zuverlässige Quelle. Selbst die Wikipedia verweist lieber auf Quellen, die eigentlich ja diesen etablierten Kriterien entsprechen. Also einer Print-Edition zum Beispiel. Bei Blogs, also jeder kann einen Blog hosten und jeder kann auf seinem Blog das schreiben, was er eigentlich möchte. Es gibt aber auch wissenschaftliche Blogs. Wie kann ich unterscheiden, wenn ich einen Blogbeitrag lese, ob das ein wissenschaftlicher Blogbeitrag ist oder ob es einfach ein x-beliebiger Mensch, der seine Meinung sagt zum Beispiel. Wie kann ich diese Qualität gewährleisten?"

Und das sind nicht die einzigen Probleme, mit denen die Digital Humanities zu kämpfen haben.

"Es gibt heute die immer weiter verbreitete Annahme, dass sobald alles digitalisiert ist, man, erstens, alles sehr schnell finden kann. Und zweitens: das alles umsonst ist. Oder zumindest fast umsonst. Und das ist beides nicht richtig."

Franco Moretti, vergleichender Literaturwissenschaftler und ein Experte für den europäischen Roman.

"Wir machen zum Beispiel gerade eine Untersuchung über die Gothic Novel. Und in unserer Datenbank haben wir nicht die 519 Gothic Novels, die diese neue Bibliografie ausweist. Also haben wir ein Sample gebildet, wie Naturwissenschaften das machen. Von den 85 zufällig ausgewählten Büchern des Samples hatten wir in unserer Datenbank, die schon ziemlich groß ist, nur 30 vorliegen. Wir sind an der Stanford Universität, einer Uni, die sehr viel Geld hat. Und wir arbeiten eng mit Bibliotheken zusammen. Trotzdem haben wir nach ungefähr sechs Monaten gerade einmal ein paar der fehlenden Texte erhalten. Es läuft alles sehr langsam und wir werden sehr glücklich sein, wenn wir am Ende 70 % unseres Samples zusammen bekommen. Der Rest ist unerschwinglich teuer."

Moretti, Jahrgang 1950, ist einer der Stars der Digital Humanities. An der Stanford University leitet er das Literary Lab, eine Einrichtung, die sich von traditionellen literaturhistorischen Forschungsinstituten deutlich unterscheidet. Hier arbeiten nicht einzelne Forscher für sich im stillen Kämmerlein, sondern Projekte werden im Kollektiv angegangen, zu dem sowohl Literaturwissenschaftler als auch Programmierer gehören. Im Mittelpunkt der Forschung steht außerdem nicht der einzelne Text, sondern eine große Menge an Texten. 4000 Romane umfasst die Datenbank des Literary Lab – eine Masse, die für einen einzelnen Wissenschaftler kaum zu bewältigen wäre. Deshalb übernimmt das der Computer. Für Franco Moretti eine Möglichkeit, die Perspektive der Literaturwissenschaft zu erweitern.

"Ich glaube, es ist wichtig, weil wir einen engen Blick auf die Literaturgeschichte haben. Sie basiert auf einem klitzekleinen Ausschnitt der Bücher, die tatsächlich geschrieben und veröffentlicht wurden. Um zu einem umfassenderen Bild zu kommen, können wir Literatur nicht mehr auf die Art und Weise untersuchen wie bisher. ´Close reading` kann man nur betreiben, wenn man sich auf ein paar wenige Bücher beschränkt."

"Close Reading" - so nennt man die vor allem in der Literaturwissenschaft der USA bedeutende Praxis, Texte oder sogar nur einzelne Ausschnitte eingehend und im Detail zu interpretieren. Franco Moretti – mit der Lust an der polemischen Provokation – nennt sein automatisiertes Verfahren "Distant Reading". Wo andere auf Nähe setzen, geht er bewusst auf Abstand.

"Distanz ist eine Bedingung des Wissens. Sie ist nicht das Hindernis. Man sieht sich nicht einen einzelnen Text aus der Nähe an, sondern man sieht sich zehntausend Texte an. Gleichzeitig. Man sucht nach einem Effekt in zehntausend Texten. Und deshalb muss man in derselben Distanz zu allen stehen, um das zu finden, wonach man sucht. In dieser Hinsicht ist Distanz also nichts, wovor man sich fürchten sollte, sondern etwas, was einem erlaubt, ein bestimmtes Wissen zu erlangen, das anders nicht zu erlangen wäre."

Zum Beispiel in Bezug auf den literarischen Realismus des 19. Jahrhunderts. Ein Stil, der als sehr analytisch gilt.

"Das heißt: Statt eine einzelnen Idee zu benennen, unterteilt man sie in ihre Bestandteile. Man sagt nicht: ´Ich betrat einen schönen Raum.`, sondern man beschreibt die Tür, die Decke, die Bilder an der Wand und so weiter. Außerdem gilt dieser Stil als sehr präzise. Man sagt nicht einfach: ´Da hingen schöne Bilder`, sondern ´Bilder alter Meiste` oder ´venezianische Gemälde`. Man sagt nicht: ´Die Decke war schön`, sondern ´Die Decke hatte ein Fresko im Stil von soundso`."

Morettis digitale Untersuchungen

Analyse und Präzision. Bisher habe man angenommen, so Moretti, dass dieser Stil zurückgehe auf Autoren wie Walter Scott oder George Eliot. Morettis digitale Untersuchungen zeigten etwas anderes.

"Es stellte sich heraus, dass im 19. Jahrhundert die Autoren, die am häufigsten diese Art der Rhetorik einsetzen, mir total unbekannt sind – und ich bin ein Spezialist für das 19. Jahrhundert. Die zehn Bücher, die die von uns gesuchten Merkmale am häufigsten besitzen, sind Bücher, die ich nie gelesen habe und von denen ich auch vorher nie gehört hatte."

Woran das liegt? Hier verlasse man nun das gesicherte Gelände der Statistik und begebe sich wieder ins Reich der Interpretation, so Moretti, der eine Gemeinsamkeit bei den betreffenden Autoren entdeckt hat.

"Sie waren Autoren eines einzigen Romans. Warum? Vermutlich, weil sie noch einen anderen Job hatten. Einer von ihnen war Admiral der Royal Navy, ein anderer war Banker, noch ein anderer Anwalt und so weiter. Vielleicht hat also das, was wir die Rhetorik des Realismus nennen, viel mehr zu tun mit der Rhetorik, dem Stil oder der Art zu argumentieren, wie sie für Disziplinen außerhalb der Literatur typisch sind. Dass Leute, die von Beruf nicht Romanautoren waren, sondern Anwälte, Seeleute oder Historiker oder was auch immer, diesen Stil sehr viel unbekümmerter benutzten. Und dass die sogenannten Realisten wie Scott oder Elliot sehr viel weniger realistisch sind. Dass ihre Überlegenheit als Autoren gerade damit zu tun hat, dass sie diesen Stil sparsamer einsetzten."

So überraschend die Ergebnisse des "Distant Reading" teilweise auch sind – das Verfahren hat seine Tücken. Das räumt auch Franco Moretti ein. 4000 Romane aus dem 19. Jahrhundert sind in der Datenbank des Literary Lab.

"Aber die Zahl der im Untersuchungszeitraum publizierten Bücher liegt bei ungefähr 40.000 – also noch eine Größenordnung höher. Unsere Frage war nun: Sind unsere 4.000 ein verlässliches Sample der 40.000? Und wir kamen zu dem Schluss: Nein, sind sie nicht. Denn woher stammten diese 4.000 Romane? Sie kamen aus ein paar großen Bibliotheken. Und Bibliotheken kaufen ihre Bücher schließlich nicht, um einen guten Durchschnitt abzubilden. Sie wollen gute Bücher. Es ist also wahrscheinlich, dass sie ihre Bücher aussuchen nach dem, was bereits Kanon ist oder danach, was die Leute schon kennen."

Hinzu kommt, dass alle Titel in der Datenbank auf Englisch sind.

"Das bedauere ich, aber es ist nur schwer zu ändern. Denn Programme brauchen eine konsistente Sprache. Das ist ein paradoxes und perverses Ergebnis, dass diese neuen Werkzeuge, die doch als so offen gelten, den Horizont des Kulturhistorikers zugleich einengen."

Darüber hinaus sind die automatisierten Verfahren auf einen Teil des kulturellen und linguistischen Erbes gar nicht anwendbar, bemerkt Altgermanistin Claudine Moulin.

"Korpussprachen wie das Althochdeutsche bieten sich gar nicht an für „Distant Reading“-Verfahren. Oder nicht normierte Sprachen. Solange Sie mit einem normierten Englisch der Gegenwart operieren, mag das funktionieren. Aber wie wollen Sie Distant-Reading-Verfahren entwickeln mit Textmengen, die weder normiert sind, noch in ausreichenden Mengen vorliegen, weil es sie schlichtweg nicht gibt? Also ich würde davor warnen, ausschließlich ´Distant-Reading`-Konzepte anwenden zu wollen auf geisteswissenschaftliche Fragestellungen."

Kritik an den automatisierten Verfahren

Ein Einwand aus dem Bereich der Digital Humanities selbst. Doch auch extern gibt es Kritik an den automatisierten statistischen Verfahren. Die Literaturwissenschaft dürfe darüber nicht ihren eigentlichen Kern vergessen. Roberto Simanowski.

"Das Kerngeschäft ist die Interpretation, das ist die Arbeit am Text an sich, am konkreten Text. Und eben die Argumentation und der Streit um verschiedene Perspektiven und das ist auch immer noch das Kerngeschäft, würde ich sagen. Aber es gibt immer mehr Projekte, die algorithmische Methoden einsetzen, um so mehr Erkenntnisse auf der statistischen Ebene in der Literaturwissenschaft zu erzeugen."

Das könne in den Geisteswissenschaften zu einem Verdrängungswettbewerb führen.

"Es geht bei neuen Methoden und neuen Theorien ja auch immer um Positionierung im akademischen Bereich, es geht immer um Macht und Ressourcen und das ist schon zu befürchten, dass dann jener Teil (…) der Geisteswissenschaft insgesamt, der eben bei diesem alten Interpretationsmodell bleiben will, dass der durchaus Nachteile davon hat. Und irgendwann nicht mehr gefördert wird oder dass Positionen nur noch ausgeschrieben werden, wenn sie in Verbindung sind oder in Verbindung stehen oder nur noch in Verbindung mit algorithmischen Analysemethoden ausgeschrieben werden und damit das, was Literaturwissenschaft macht, in eine bestimmte Richtung getrieben wird."

Nämlich in die Richtung der Naturwissenschaften mit ihrem Exaktheits-Anspruch. Zum Versprechen von Präzision, Eindeutigkeit und Transparenz, das immer dann winkt, wenn Zahlen ins Spiel kommen. Von einem "Quantitative Turn" in den Geisteswissenschaften ist schon die Rede. Wenn der vollzogen würde, wäre das ein Fehler, findet Simanowski.

"Die gesellschaftliche Funktion der Geisteswissenschaft liegt darin, dass sie dem positivistischen, technischen Wissen, der Ingenieurswissenschaften, der Naturwissenschaften, die Ungenauigkeit des geisteswissenschaftlichen Wissens entgegensetzt."

Simanowski bezieht sich hier auf den Philosophen Odo Marquardt. Der sah den Mangel an Genauigkeit in den Geisteswissenschaften nicht als Nachteil, sondern als Vorteil.

"Als Vorteil deswegen, weil dies auch sensibilisiert für verschiedene Perspektiven, dafür dass sich immer wieder Perspektiven auch ändern, ja das Ungenaue der Geisteswissenschaften ist ja, dass nichts feststeht, dass alles weiter diskutiert werden kann, und dieses Gefühl, sagt er, ist wichtig aus gesellschaftspolitischer Perspektive, um das Gefühl wach zu halten, dass es nicht nur eine Perspektive auf die Dinge gibt und daran sähe ich die Gefahr, dass jetzt vielleicht mit einem Quantitative Turn eine solche Perspektive auf die Vagheit des Wahrheitsgeschäftes zur Seite geschoben wird."

Die Forschungen des Franco Moretti

Eine Einschätzung, der sich allerdings auch Franco Moretti anschließt. Der Forscher, der zurzeit wie kaum ein anderer für die statistische Ausrichtung der Literaturwissenschaft steht.

"Die Abschaffung von Unbestimmtheit ist ein verrücktes Begehren. Viele Konzepte sind unbestimmt. Zum Beispiel das Konzept ´rot`. Natürlich könnten wir Konzepte präziser machen. Wir könnten sagen: ´Rot ist ganz genau der und der Teil des Farbspektrums zwischen Wert x und Wert y.`. Aber dann würden die Konzepte ihren Wert verlieren. Sie sind wertvoll, weil sie unbestimmt sind. In allen Gebieten immer ganz präzise sein zu wollen, das ist für mich ein verrückter Orwell'scher Alptraum."

Aber ist dieser Alptraum wirklich zu befürchten? Graben die digitalen Methoden mit ihrer Verlockung der Präzision den Geisteswissenschaften das Wasser ab? Claudine Moulin widerspricht.

"Es geht vielmehr um ein Miteinander der Methodologien. Ich glaube man sollte das nicht trennen. Wir sind alle digital geworden und es ist an uns, zu entscheiden, wo es sinnvoll ist, digitale Methoden anzuwenden. Die ältesten Spuren des Deutschen, das kann ich mit keiner digitalen Methode bis heute machen. Also es geht darum, eine gute Kombination von beidem anzuwenden."

Fließen die Forschungsgeldern leichter, wenn das Schlagwort "Digital Humanities" im Antrag steht? Die Germanistin Anne Baillot:

"Jein, also Digital Humanities kosten Geld, das sind sehr teure Projekte, wenn ein Förderer sich entscheidet, ein Digital Humanities Projekt zu fördern, dann heißt es, das es drei oder vier andere nicht digitale Projekte nicht fördert."

Und genau das habe wiederum häufig die Auswirkung, dass digitale Forschungsprojekte nicht gefördert werden. Zumal es aufwendig sei, die so teuer erforschten Ergebnisse auch über einen langen Zeitraum verfügbar zu halten. Papier ist geduldig. Im Internet herrscht stetiger Wandel.

"Wenn ich eine digitale Ressource aufbaue, muss die aktualisiert werden, wenn die Browser aktualisiert werden, sonst ist es einfach nicht mehr einsehbar, nicht mehr konsultierbar. Das heißt, es geht nicht darum, dieses Produkt einmal fertig zu stellen, sondern jemand muss dahinter stehen und immer wieder sicher machen, okay die Scripts funktionieren noch oder ich muss die Scripts aktualisieren, weil die Browser sich geändert haben usw."

Arbeitsteilung in der Zukunft

Wobei hier keine Missverständnisse aufkommen sollten: ein ´digitaler` Geisteswissenschaftler zu sein, bedeutet nicht, dass man programmieren können muss.

"Ich bin zum Beispiel jemand, der überhaupt nicht technikaffin ist und das hindert mich nicht daran, mich als digitale Geisteswissenschaftlerin zu empfinden. Ich glaube, was nicht wirklich wahrgenommen wird, ist, dass es im Bereich Digital Humanities viele unterschiedliche Profile gibt und dass man die alle braucht. Man braucht die Leute, die die Technik entwickeln. Man braucht die Leute, die die Fragestellung entwickeln. Man braucht die Leute in der Mitte."

Deshalb sei auch kollaboratives Arbeiten in Gruppen und Netzwerken besonders prägend.

Wenn ich jetzt zum Beispiel eine digitale Edition nehme, dann brauche ich natürlich den Philologen, der die Transkription machen kann, möglicherweise ist er auch der Gleiche, der die Kodierung macht, aber ich brauche noch jemanden, der diese Kodierung in html wandelt und dann auch die Person, die das Webdesign entwickelt. Damit dann die Edition tatsächlich nutzbar ist und das ist wirklich eine Kette von Kompetenzen, die verlangt, dass man in Gruppe arbeitet.

Arbeiten in der Gruppe statt im stillen Kämmerlein. Auch das mögen manche Geisteswissenschaftler eher ablehnen. Hier herrscht oft noch das Ideal des einsamen Denkers, der die Tür fest hinter sich zu macht.

"Das ist ein Mythos, das offenbar besteht und wenn man sich die Geschichte der Wissensgeschichte in Europa anschaut, auch die mittelalterlichen Mönche haben in der Gemeinschaft Wissen erzeugt. Wenn Sie sich einen Codex anschauen, da sehen Sie 10/15/30 Hände, die kollaborativ einen Codex annotiert haben und da sieht man, dass die gemeinsam Wissen erzeugt haben."

Wer weiß, vielleicht hätten die mittelalterlichen Mönche aus der Benediktinerabtei St. Matthias, deren Bibliothek Claudine Moulin und ihre Kollegen erforschen, gar nicht so viel gegen die modernen Methoden der Digital Humanities einzuwenden gehabt.