Mit zwei Klicks in die Filterblase

08:00 Minuten

Von Philip Banse · 22.09.2018

Eigentlich will YouTube nur Geld verdienen - doch das hat politische Nebenwirkungen. Denn der Algorithmus begünstigt radikale Inhalte und kreiert dadurch Filterblasen. Doch führt das wirklich zur Radikalisierung von Massen, wie die Soziologin Zeynep Tufekci meint?

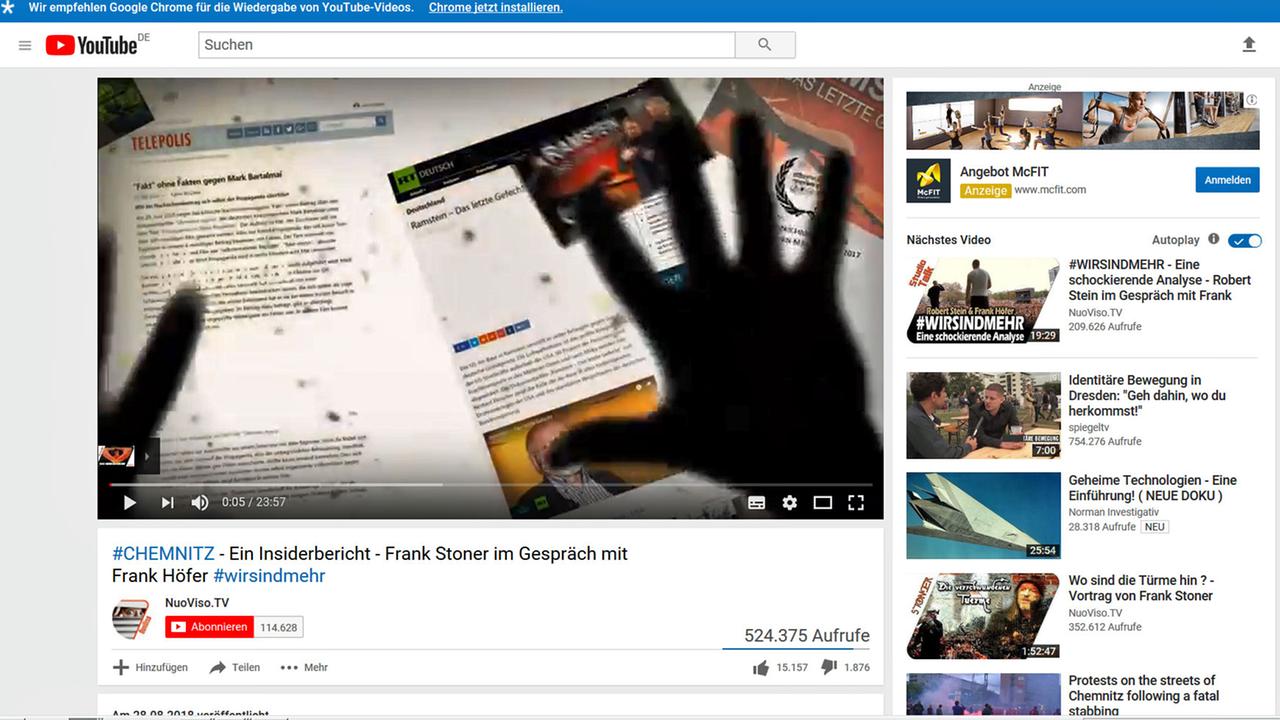

Der Leipziger Youtube-Sender "NuoViso", zwei Tage nachdem Daniel H. in Chemnitz getötet worden war. Ein Tag, nachdem Tausende, darunter viele Rechtsradikale, durch Chemnitz gezogen waren. Frank Stoner, ein Mann, der auch verschwörungstheoretische Vorträge zu 9/11 hält, verbreitet Falschinformationen zum Tod von Daniel H:

"Es wird sich halt erzählt, dass da am Anfang zwei Frauen waren, die auf dem Weg zu ihrem Auto waren..."

Schon nach kurzer Zeit haben sich eine halbe Million Menschen dieses Video auf Youtube angesehen.

Ein sich selbst verstärkender Prozess: Wer bestimmte Youtube-Videos ansieht, bekommt oft ähnliche Inhalte angezeigt.© Screenshot Youtube

Üblicherweise locken die Videos von "NuoViso" nur einige Tausend, manchmal 40.000 oder 50.000 Zuschauer an. "Wie kann das sein?", fragte sich Raymond Serrato, ein in Berlin lebender Daten-Analyst, und sah sich die Sache mal näher an:

"Ich wollte wissen, welche Videos Nutzer zu sehen bekommen, wenn sie bei Youtube Chemnitz als Suchbegriff eingeben", sagt Serrato. "Hauptfrage war: Was für Informationen sind das? Welche Art von Videos werden hochgeladen?"

Extreme Videos werden oft geklickt

Wenige Tag nach den Ausschreitungen fand Serrato auf Youtube zum Suchbegriff "Chemnitz" 530 Videos aus den letzten zehn Jahren. 200 davon waren innerhalb der letzten Woche hochgeladen worden.

"Rechte und verschwörungstheoretische Videos sind die beliebtesten Videos zum Thema Chemnitz, und es zeigte sich, dass diese nach dem Todesfall von Daniel H. extrem schnell hochgeladen wurden."

Neben jedem Video empfiehlt Youtube in der rechten Spalte per Algorithmus weitere Videos, die auch automatisch abgespielt werden. Serrato fand heraus: Wer rechte und verschwörungstheoretische Videos zum Suchwort "Chemnitz" guckt, bekommt von Youtube weitere rechte verschwörungstheoretische Videos empfohlen mit Titeln wie "Donald Trump - Das trojanische Pferd der Rothschilds" oder "Alice Weidel (AfD) über Kopftuchmädchen".

Die Erkenntnisse des Datenanalysten Raymond Serrato scheinen empirisch zu belegen, was die US-amerikanische Soziologin Zeynep Tufekci bisher nur anekdotisch festgestellt hat. Auch Tufekci hatte sich angesehen, welche Videos der Youtube-Algorithmus rechts neben den Videos vorschlägt, die sie sich gerade ansieht. Ihr Befund: Youtube sei "eines der mächtigsten Radikalisierungs-Instrumente des 21. Jahrhunderts".

"Dir wird schnell ISIS-artiger Kram vorgeschlagen", sagt Tufekci in der "Ezra Klein Show".

"Oder du willst etwas über eine Krankheit erfahren, die du hast, dann werden dir sehr schnell Videos von Impfgegnern gezeigt."

Radikalisierung in Einzelfällen möglich

Als sie sich Reden von Donald Trump ansah, schlug Youtube ihr schnell Videos von Holocaust-Leugnern vor oder regelrechten "Nazi-Kram", wie sie sagt.

"Und jetzt sind wir hier und setzen Milliarden Menschen immer extremere Inhalte vor - nur, weil sie alles einem Algorithmus überlassen, dem sie gesagt haben: Halte die Leute auf unserer Website, damit wir ihnen Werbung anzeigen können. Denn das ist ihr Geschäftsmodell."

Denn wenn Youtube immer mehr Videos vorschlägt, die Nutzer anklicken, bleiben diese länger auf der Seite, können mehr Werbung sehen und Youtubes Kassen füllen. Führt das aber zu einer Radikalisierung der Massen, wie die Soziologin Zeynep Tufekci aufgrund ihrer eigenen Erfahrungen insinuiert?

"Ich würde es nicht so radikal wie Zeynep Tufekci sehen", sagt Jonas Kaiser, der gerade an der Harvard-Universität untersucht hat, welche Folgen der Youtube-Algorithmus für die Gesellschaft hat.

"Youtube kann in Einzelfällen zu Radikalisierung führen. Ich wäre äußerst vorsichtig, dies zu generalisieren, ganz einfach, weil wir dazu keine Daten haben."

Rechte Akteure sind besonders präsent

Dennoch habe die Logik des Youtube-Algorithmus, Zuschauern immer mehr von dem vorzuschlagen, was sie mögen, zu einem bedenklichen Effekt geführt:

"Grundsätzlich sieht man, dass Youtubes Algorithmus sehr gut funktioniert, so genannte Filterblasen zu kreieren. Das sind Blasen, die innerhalb eines bestimmten Spektrums kaum durchlässig sind, und in denen bewegt man sich dann."

Heisst: Wer Rockmusik mag, dem schlägt YouTube mehr Rockmusik-Videos vor.

"Bei Politik führt das eben leider dazu, dass man sagt: Du magst Politik? Du hast ein Video vom ZDF angeschaut. Hier ist ein Video von der AfD oder hier ist ein Video von Russia Today, und so kommt man quasi in diese rechte politische Blase. Und da ist es sehr schwer wieder rauszukommen, da eben die rechten Akteure auf YouTube viel präsenter sind als andere."

Bedenklich daran ist laut Kaiser: Es kommt nicht darauf an, wie die Realität ist, sondern wie wir sie wahrnehmen – weil die Konsequenzen daraus sehr wohl real seien. Wenn Jugendliche also in einem Kosmos aus Verschwörungstheorien, Falschmeldungen und Angst-Videos hängen, ist es egal, ob das alles stimmt oder nicht. Wenn die Jugendlichen es für die Realität halten, sind ihre Handlungen, die daraus folgen, auch real, für alle.

Eine Youtube-Sprecherin sagte der New York Times, Youtube mache "den Menschen Video-Vorschläge, die sie zufrieden machen". Und gibt uns YouTube nicht einfach das, was wir wollen? Wir müssen uns ja keine rechtsradikalen Videos anschauen, wenn wir das nicht wollen. Menschen handelten nicht immer rational, argumentiert die Soziologin Zeynep Tufekci. Wir hätten eine Schwäche für neue, extremere Inhalte:

Was wir im Kern machen, sagt sie, sei zu sagen: Ok, da gibt es diese menschliche Schwäche, dass wir Sachen suchen, die neu sind und aufregender. Und dann machen wir diesen Algorithmus, der das ausnutzt bei Milliarden Menschen, um Geld zu machen. Ich denke, das sollten wir nicht zulassen.

Bedroht der Markt die Meinungsvielfalt?

"Der Algorithmus, der die sehr emotionale, aufpeitschende, aber auch vielleicht falsche Nachricht verbreitet, der führt zu Erträgen, sagt Uwe Conradt, Direktor der Landemedienanstalt des Saarlands.

"Das ist erstmal per se in Marktwirtschaften nicht verboten. Das ist aber mit Blick auf das Thema: 'Wie wirkt das auf die Meinungsvielfalt?' ein Problem."

Längst ist die Diskussion darüber entbrannt, wie die großen Plattformen dazu gebracht werden können, ein ausgewogeneres Abbild der Wirklichkeit zu liefern. Die Plattformen übernehmen mehr und mehr selbst Verantwortung, sperren Hetzer. Die Youtube-Sprecherin sagte der New York Times auch: Die Firma plane mit Nachrichten-Organisationen zu arbeiten, um auf YouTube "eine besseres Nachrichten-Erlebnis" zu erzeugen.

Und wer heute, Wochen später, bei YouTube nach "Chemnitz" sucht, findet fast ausschließlich Videos etablierter Massenmedien. Das liege an der Zeit, sagt Harvard-Forscher Kaiser: Direkt nach den Ausschreitungen seien schnell vor allem rechte Videos hochgeladen worden und daher sehr sichtbar gewesen.

"Mit der Zeit natürlich haben klassische Massenmedien auch Videos hochgeladen, und da eben sehr viele Menschen daran interessiert waren in Deutschland und darüber hinweg und die aber gleichzeitig nicht an rechten und verschwörungstheoretischen Inhalten interessiert sind, haben die natürlich auch immer mehr die klassischen Medienvideos geklickt, was die hohen Klickzahlen erklärt, aber gleichzeitig auch deren Prominenz in der Suchergebnisliste."

Aber auch neben einem Video der Tagesschau empfiehlt YouTube ein Video der AfD. Die Blase ist oft nur zwei Klicks entfernt.