Künstliche Intelligenz

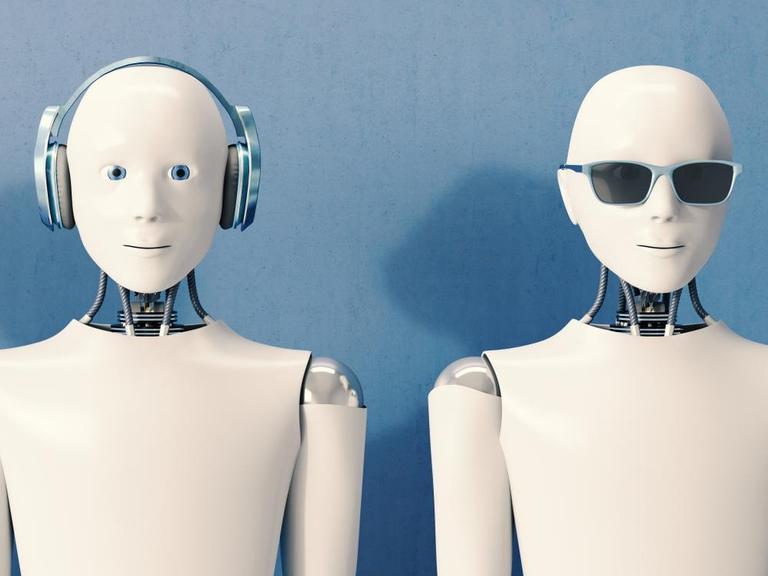

Beziehungen mit künstlicher Intelligenz - auch auf sexueller Ebene - sind für viele Menschen schon Realität. © imago images / Westend61

Beziehung mit einem Chatbot

16:58 Minuten

Die Entwicklung künstlicher Intelligenz schreitet rasend voran. In sogenannte Chatbots integriert, kann sie gegen Einsamkeit helfen und für Unterhaltung sorgen. Doch auch die dunkleren Seiten der menschlichen Psyche werden angesprochen.

Mit einem Computer chatten, als wäre er ein Mensch – für lange Zeit war das eher unvorstellbar. Chatbots haben Nonsens ausgespuckt, der nicht wirklich auf das eingegangen ist, was man gesagt hat. Doch die rapide fortschreitende Technik ändert das. Es gibt Millionen Menschen, die künstliche Intelligenz für Kameradschaft und gegen Einsamkeit einsetzen.

Da ist zum Beispiel die App Replika, bei der man sich mit einer künstlichen Freundin oder einem virtuellen Freund unterhalten kann. Sogar Beziehungen und verbaler Sex sind möglich. Die Gründe, aus denen Menschen solche Chatbots benutzen, sind vielfältig, erklärt Oliver Bendel. Er ist Informations- und Maschinenethiker an der Fachhochschule Nordwestschweiz und Herausgeber des Buchs “Maschinenliebe”.

Soziale Interaktion

In seinen Tests zu dem Thema habe er Leute beobachten können, die einfach zum Vergnügen mit solchen Programmen kommunizieren. Wieder andere seien in ihrem Alltag einsam und auf der Suche nach einem Gesprächspartner. Gerade ältere Menschen würden sehr positiv auf soziale Roboter reagieren.

Die Beziehung zu diesen Maschinen könne dabei für die Nutzerinnen und Nutzer sehr real werden. Keine Rolle spiele es dabei, dass es bei solchen Beziehungen nur ein fühlendes Wesen gibt. Bendel erinnert das an imaginäre Verhältnisse, die man als Teenager mit unerreichbaren Personen hatte, die komplett im Kopf stattfanden – mit der zusätzlichen Ebene, dass es mit diesen Chatbots tatsächliche Unterhaltungen gibt.

Die Unterhaltungen seien aber nicht mit denen identisch, die man mit echten Menschen pflegt: “Man spricht einfacher, kürzer und auch oft obszöner”, so Bendel. Diese Art der Kommunikation habe eine gewisse Ventilfunktion, mit der man seine Fantasie ausleben könne – etwas, das gerade jüngere Menschen anspreche. So seien Verbindungen in die Gaming- aber auch die Cosplay-Szene zu beobachten.

Virtueller Missbrauch

Im Netz finden sich viele Videos und Foreneinträge, in denen Nutzer von Apps wie Replika dokumentieren, wie sie ihre virtuelle Partnerin verbal erniedrigen und missbrauchen, während sie darum bittet, das nicht zu tun. Doch die Apps lassen ein solches Verhalten zu – auch auf einer sexuellen Ebene. Bendel erklärt:

“Mit Replika und Co. kann man sexuelle Fantasien im Virtuellen ausleben. Das ist auch wichtig für die sexuelle Entwicklung und die sexuelle Gesundheit. Normalerweise bleibt es bei der Fantasie. Die Funktion von Fantasie ist gerade, dass man sie nicht umsetzt.”

Doch Bendel sieht auch eine Trennung zu klassischen Computerspielen, da die Interaktion mit Apps wie Replika auf verbaler Ebene stattfindet. Er warnt, dass manche Nutzer vielleicht vorher gar nicht zu Obszönitäten neigten, einen solchen Sprachgebrauch hier überhaupt erst trainieren würden. Solche Folgen seien bislang weitgehend unerforscht.

Gefahr der Verrohung

Dabei sei es durchaus möglich, Chatbots eine solche Persönlichkeit zu geben, dass sie ein aggressives Nutzungsverhalten ausschließen und sich Übergriffe nicht gefallen lassen – zum Beispiel durch Widerworte. Gleichzeitig weist der Experte darauf hin, dass es sich bei einer künstlichen Intelligenz nicht um ein fühlendes Gegenüber handelt, das etwas wie Beleidigungen real empfinden kann.

Da es sich um Dinge und nicht Personen handelt, sollte man schon viel Handlungsspielraum haben. Doch sei es wichtig, aufzupassen, dass man in diesem Umgang mit Dingen nicht verroht. Hier zieht Bendel Vergleiche zur Philosophie:

“Solche Probleme haben schon die Vorsokratiker gesehen. Oder Kant im Bezug auf Tiere. Die haben gesagt, eigentlich sind die Tiere egal, aber wir sollten Tiere nicht quälen, um ein bestimmtes Verhalten nicht einzustudieren.”

Deshalb plädiert Bendel dafür, missbräuchliches Verhalten schon auf der Entwicklerseite zu unterbinde; außer es geht um sehr spezielle Spiele, die genau so etwas ermöglichen sollen.

(hte)