Wie es funktioniert, die eigene Stimme zu klonen, und wie gut – oder schlecht – es sich mit dem eigenen Stimmklon reden lässt, beschreibt Julius Stucke auch im Interview in unserer Sendung "Studio 9". Den Beitrag können Sie hier [ AUDIO ] nachhören.

Audio-Deepfakes

Dank KI werden synthetische Stimmen menschlichen immer ähnlicher. Das eröffnet Raum für gefährliche Audio-Deepfakes. © imago / Panthermedia / kentoh

Was, wenn wir unseren Ohren nicht mehr trauen können?

30:55 Minuten

Die eigene Stimme klonen, das ist längst keine Zukunftsmusik mehr. Maschinen können Dinge sagen, die echt klingen, aber nicht echt sind. Das hat gravierende Auswirkungen auf unser Vertrauen in wahrhaftige Kommunikation – und auf die Demokratie.

"Ich bin CEO und Co-Founder von einem Start-up für KI. Pinscreen", stellt sich Hao Li in der Videokonferenz vor. "Wir bauen im Prinzip realistische virtuelle Menschen für Anwendungen wie virtuelle Assistenten und Virtual Fashion und so weiter."

Kann man sicher sein, dass tatsächlich er es ist, der gerade spricht?

"Nicht unbedingt", sagt er und lacht. "Es kann sein, dass ich irgendjemand anderes bin."

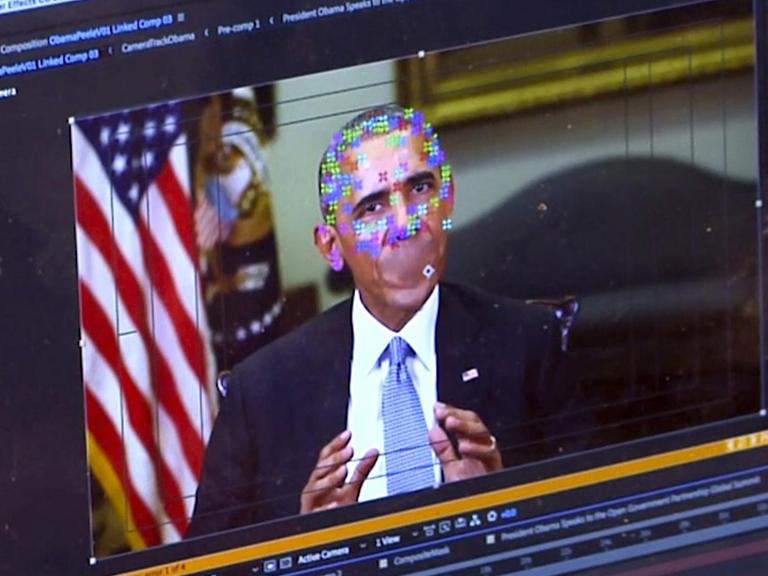

Hao Li arbeitet daran, in Echtzeit möglichst realistische künstliche Videos zu erzeugen. Dass wir unseren Augen nicht unbedingt immer trauen können, ist nicht ganz neu. Bilder wurden schon manipuliert, bevor sie laufen lernten. Auch künstliche Videos, Deepfakes, drehen schon eine Weile ihre Runden. Fake, weil es nicht echt ist, Deep, weil es mit Hilfe von Deep Learning, also künstlicher Intelligenz, erstellt wird. Dass das bald in Echtzeit und für unser Auge kaum erkennbar möglich sein soll, ist etwas beängstigend!

"Aber unser Ziel ist es nicht, Deepfakes zu kreieren. Das Ziel ist im Prinzip, extrem realistische virtuelle Avatare zu erzeugen. Das mit der Täuschung kam mir nie in den Sinn. Ganz am Anfang war unser Ziel immer Hollywood. Wie kann man Spezialeffekte perfektionieren, wie kann man diese Effekte billiger erzeugen, wie kann man die Technologie demokratisieren?"

Kann man sich einen Stimmklon erschaffen?

Verblüffend gut lässt sich das Gesicht in einem Video austauschen: ein Face-Swap. Oder die Mundpartie und die Mimik eines anderen steuern wie eine Puppe. Mimik und vor allem der Ton, die Stimme, kommen bei den Beispielen gerade von Imitatoren. Also von echten Menschen. Ich will herausfinden, ob das auch synthetisch geht. Und vor allem: besser. Denn wir haben ja um uns herum schon viele künstliche Stimmen, nur klingen die meist eben auch künstlich.

Was macht all der Zweifel am Sehen und Hören mit uns? Ist das am Ende gefährlich für die Demokratie? Schaffen wir Menschen uns künstliche Gegenüber, zum Beispiel einen Stimmklon, und uns damit ab?

Ich mache mich auf die Suche nach künstlichen Stimmen und finde erst mal einiges, das mehr verspricht, als es halten kann. Oder das unfreiwillig komisch ist.

Ausgefeiltere Lösungen wurden in den letzten Jahren etwa von Softwaregrößen wie Adobe showreif präsentiert, aber dann nicht wirklich weiterverfolgt. Artikelüberschriften klingen oft groß: "Diese KI klont jede Stimme mit wenigen Sekunden Material", aber nicht immer sind sie überzeugend.

Abgesehen von der Qualität – das meiste ist beschränkt auf englische Klone. Das kanadische Start-up "Resemble.AI" aber verspricht verschiedene Sprachen. Ich maile mit Gründer Zohaib Ahmed hin und her und freue mich, als er antwortet "I‘d be happy to clone your voice". Ich schicke ihm fünf Minuten Sprachmaterial. Am nächsten Tag ist er fertig:

Autor Julius Stucke hat sich für sein Feature den Stimmklon "Fulius" geschaffen, der ihm akustisch mehr ähnelt, als ihm lieb ist.© Deutschlandradio

"Und hatte fast doppelt so viel Hals wie üblich, was sich als sehr nützlich erwies, da sie so viel Zeit damit verbrachte über Gartenzäune zu krabbeln und die Nachbarn auszuspionieren."

Damit wird man niemanden täuschen. Aber meinen Klang erkenne ich schon wieder. Das Potenzial wird deutlich. Nur: Wie funktioniert das Ganze und warum dann doch nicht so richtig?

"Wir haben ein Stück deiner Daten in ein neuronales Netzwerk gegeben", erklärt Zohaib. "Das schaut sich dein Audio und den Text an und versucht, zu sagen, welcher Text zu welchem Audio gehört. Davon ausgehend lernt es Sequenzen und lernt, wenn dieser Laut auf diesen Laut folgt und dann auf diesen, dann klingt es am Ende also so.

Warum das in meinem Beispiel so schlecht funktioniert hat: Zohaibs Maschine hat meine Stimme zuerst in Text umgewandelt und dann Text und Audio verglichen. Da solche Umwandlungen von Sprachaufnahmen in Text oft Fehler enthalten und da sein Team diese Fehler wegen fehlender Deutschkenntnisse nicht verstehen und erkennen konnte, hat die Maschine manches falsch gelernt.

Täuschungsversuch per Sprachnachricht

Während Zohaib Ahmed verspricht, weiter an meiner deutschen Stimme zu basteln, versuche ich es mit einem Tool von Descript. In Zeiten einer boomenden Podcastbranche, in Zeiten von Youtube gibt es hier eine "Alles in einem"-Plattform: Nimm Audio auf, lass es in Text umwandeln, bearbeite ihn direkt, eliminiere automatisch Füllwörter und ändere auch Wörter, die du nicht oder falsch aufgenommen hast. Ohne noch mal ins Studio zu müssen. Descript verspricht dabei, besser zu klingen als synthetische Stimmen von Google oder Amazon, und in der Tat ist die Soundqualität beeindruckend.

Zeit für einen Täuschungsversuch. Ich schicke einer Freundin, die in Australien lebt, eine Sprachnachricht. Ein kurzes Lebenszeichen mit der Hoffnung, dass es ihr gut geht.

"Hope everything is fine with you two. It is so sad we can‘t see because of this damned Corona. Would be great to hear from you. Say Hi to Tom please and take care. Julius."

Der Kontext spielt natürlich eine Rolle. Sie bekommt es von meinem Telefon – vertrauenswürdig. Ich schicke ihr sonst keine Sprachnachrichten, geschweige denn auf Englisch – verdächtig. Sie hat sich aber nicht gefragt, ob ich es bin:

"Die erste Nachricht war ein bisschen abgehackt. Es hat sich so angehört, als ob du irgendein Aufnahmeprogramm ausprobierst oder so was. Es war ein Teil der Intonation, der einen stutzig macht. So nach dem Motto: Es hört sich ja nicht ganz normal an, was ist denn das und dann sucht man dafür Erklärungen, wie gesagt, ob du was ausprobiert hast. Schon ein bisschen beängstigend."

Noch nicht perfekt, ja! Aber einzelne Wörter oder Teile eines Satzes könnte man tauschen – ohne dass Menschen es erkennen. Menschen, die sich in diesen Zeiten sowieso schon zunehmend an wackelige Videokonferenzen oder den einen oder anderen digitalen Soundaussetzer gewöhnen. Und wir reden von KI-Systemen, die sich schnell weiterentwickeln. Die sogar anfangen zu singen, ohne je gesungen zu haben, oder Emotionen aus dem Nichts einer synthetischen Stimme hinzufügen. Mellotron nennt sich diese Spielerei.

Synthetische Stimmen sprechen oft zu perfekt

Spannend bleibt, ob die künstlichen Stimmen irgendwann auch ihre große Schwierigkeit überwinden: die Komplexität unserer gesprochenen Sprache. Das Menschliche.

"Wir bekommen immer den Hinweis: Das Ergebnis klingt zu perfekt", sagt Zohaib Ahmed. "Und Menschen sind nicht perfekt. Wir haben Füllwörter, Pausen, wir variieren das Tempo beim Sprechen, sprechen nicht flüssig.

Deshalb experimentieren Zohaib Ahmed und seine Firma Resemble.AI mit einer Mischform. So wie bei Videos bereits verbreitet: Die eigene Mimik über das Bild eines anderen legen und den anderen so steuern.

"Wenn wir deine Stimme kontrollieren wollten – und wenn ich deutsch sprechen könnte – dann würde ich den Satz so sagen, wie ich mir vorstelle, dass du ihn sagen würdest oder so, wie ich möchte, dass du ihn sagst. Wir würden meinen Rhythmus nehmen, aber dein Timbre behalten. So kann man Dinge machen wie Lachen, Rhythmus kontrollieren, Stottern. Darauf arbeiten wir hin."

Sie tun das nicht, um irgendwen zu täuschen, um Fakes zu ermöglichen. Das ist mit ihrem Tool auch schwierig, denn Maschinen wie die von Resemble.AI oder auch Descript, woher mein englischer Klon stammt, die muss ich mit Material trainieren, mit meinen Texten und meinen Sätzen, die ich von jemand anderem nicht einfach bekommen kann. Aber es gibt auch Open-Source-Tools, die diese Beschränkung nicht haben. Die meisten davon basieren auf dem "Tacotron 2"-System von Google, das hat schon vor einigen Jahren Original und Synthese sehr nah aneinander gebracht.

Was ich mich aber frage: Möchte ich eigentlich Navigationsgeräte, Bahnansagen, Service am Telefon und andere künstliche Stimmen, die als solche kaum oder gar nicht mehr zu erkennen sind? Ist es nicht ganz gut, zu hören und zu wissen, dass da eben manchmal kein Mensch dahintersteckt?

Ist es nicht sogar besser, wenn künstliche Stimmen, wie etwa bei Bahnhofsdurchsagen, gar nicht täuschend echt klingen, fragt Autor Julius Stucke.© imago / imagebroker

Während die einen daran arbeiten, die Täuschung oder das Künstliche zu perfektionieren – versuchen andere, Wege zu finden, Fakes zu entlarven. Am Fraunhofer-Institut für Digitale Medientechnologie im thüringischen Ilmenau arbeiten Patrick Aichroth und sein Team in der Audioforensik. Sie versuchen mit technologischen Verfahren, Manipulationen in Audiodateien zu erkennen. Oft geht es um Betrugsfälle.

"Es gab aber auch schon Fälle, auch im journalistischen Bereich, wo wir mitgekriegt haben, dass Material zum Beispiel zum Anheizen eines lokalen Konfliktes in einem Bürgerkriegsgebiet benutzt wurde, wo wir ganz klare Hinweise darauf fanden, dass dieses Material manipuliert war", sagt Aichroth.

Deepfakes laufen ihm aber eher selten über den Weg. Meist geht es um sogenannte Shallow Fakes. Das Original wird geschnitten, ergänzt oder aus dem Zusammenhang gerissen. Da wird dann etwa in einem Verkaufsgespräch schlicht ein "Ja" an eine andere Stelle geschnitten. Simpel, aber effektiv.

"Es gibt im Moment eine Tendenz, die Deepfakes und ganz besonders eben Videos als das zentrale Problem zu identifizieren. Und das finde ich tatsächlich nicht so zielführend. Diese "cost benefit"-Überlegungen aus der Angreifersicht scheinen auch sehr wichtig."

Es bleibt ein Katz-und-Maus-Spiel

Der Aufwand der Fälscher muss sich also lohnen. Wenn Aichroth und sein Team die Aufgabe bekommen, Audiomaterial zu überprüfen, gibt es viele verschiedene Wege, sagt er.

"Die wichtigsten sind Codecanalyse, Mikrofonanalyse und elektrische Netzfrequenz."

Mit Codecanalyse meint er: Wurden unterschiedliche Teile eines Satzes oder einer Rede verschieden bearbeitet, digital oder etwa unterschiedlich stark komprimiert? Ähnlich bei den Mikrofonspuren. Finde ich in einer Rede Hinweise auf verschiedene Mikrofone, ist das verdächtig. Die elektrische Netzfrequenz, genauer: die Schwankungen unseres Stromnetzes, ergeben auch so was wie einen Fingerabdruck, der helfen kann. Hilft ihm all das auch, wenn synthetisches Audiomaterial hinzukommt?

"Die Herausforderung besteht darin, für synthetisches Material das Wissen und Know-how für natürliche Aufnahmen zu benutzen. Was aber viel schwerer wird, wird eine etwas haltbare Detektion zu entwickeln, die auch über etwas längere Fristen hinweg funktionieren wird."

Es wird also ein Katz-und-Maus-Spiel bleiben.

Vertrauen in die Sprache droht verloren zu gehen

Firmen wie Resemble.AI zeigen sich ihrer Verantwortung bewusst und wollen auch Tools zum Aufdecken von Fälschungen bereitstellen. Am Fraunhofer-Institut in Ilmenau gibt es das Projekt "Digger", das neben den Fakes durch Schnitte und Ähnliches zukünftig auch lernen soll, Deepfakes zu erkennen.

Ich möchte das testen. Können Patrick Aichroth und sein Team meine englischen Sätze als synthetisch entlarven? Auch wenn ich sie mische? Einen normalen Satz mit ein, zwei künstlichen Wörtern drin? Nach einigen Tagen habe ich eine Antwort im Postfach. Die mich nicht unbedingt beruhigt: Es gebe zwar Auffälligkeiten, aber so richtig sicher erkennen, was da stimmt und was nicht, klappt nicht. Aussagen, die sie falsifizieren könnten, würden es erleichtern. Nach dem Motto: Das soll so und so aufgenommen worden sein – prüft, ob das stimmen kann. Aber automatisch lässt sich die Synthese noch nicht erkennen.

Was droht, wenn wir nicht in der Lage sind, Fake und Echtes zu unterscheiden? Erleben wir eine Flut an Desinformation? Spektakuläre Fake-Ereignisse? Oder wird es eher ein steter Tropfen?

"Ich glaube tatsächlich, dieser Vertrauensverlust in Sprache und übertragene Sprache ist möglicherweise das viel größere Problem", sagt Patrick Aichroth.

Die Sozialpsychologin Nicole Krämer meint: "Es gibt Theorien in der Psychologie, dass wir, wenn wir etwas sehen oder hören, gar nicht anders können, als es erst mal für bare Münze zu nehmen. Das macht ja evolutionstheoretisch betrachtet auch Sinn. Wenn ich den Säbelzahntiger um die Ecke biegen sehe und erst mal überlege: Ist der real oder will mir da jemand einen Streich spielen? Dann ist es im Zweifel zu spät."

Nicole Krämer erforscht, wie uns Falschinformationen beeinflussen. Die kommen natürlich etwas anders als Säbelzahntiger um die Ecke: meist mit weniger sofortigem Handlungsbedarf. Aber gilt das Säbelzahntigergleichnis überhaupt noch bei all den Fakes, die uns schon umgeben?

"Es gibt noch keine Untersuchungen darüber, ob sich in unserer Grundeinstellung etwas verändert hat. Man kann aber theoretisch davon ausgehen, dass Dinge, die über Jahrmillionen entstanden sind, nämlich dass für uns Dinge, die wir mit eigenen Augen sehen und mit eigenen Ohren hören, erst einmal real sind. Dass sich das nicht innerhalb der paar Jahre Mediengeschichte, wo so was als Fake präsentiert werden kann, ändert an unserer Grundeinstellung. Deswegen ist es so gefährlich, weil wir diese Grundeinstellung zunächst haben: Was ich sehe, was ich höre, das ist erst mal real."

Dabei kommt es auf den Zusammenhang an, auf den Inhalt oder die Erfahrungen einer Person. Die Frage: Ist es eine gänzlich unverdächtige oder eine verdächtige Kommunikation? Wenn mich ein Anrufer mit perfekt geklonter Stimme überzeugen will, er sei mein Sohn und ich müsse dringend Geld irgendwohin überweisen, ist der Zweifel sicher mit an Bord, egal wie gut die Stimme klingt. Mittlerweile sowieso.

"Wobei natürlich – sonst gäbe es auch den Enkeltrick nicht mehr – immer noch genügend Menschen darauf reinfallen. In der Tat braucht es da noch nicht einmal die genaue Stimme, weil sich Personen dann öfter gar nicht mehr genau daran erinnern können, wie der Enkel oder die Enkelin wirklich klingen."

Fake News werden besonders gut erinnert

Wir sind psychologisch betrachtet vielleicht weniger gute Audiodetektive, als ich wahrhaben möchte. Und wir sind einigermaßen träge:

"Es gibt einen seit vielen Jahren bekannten Effekt in der Psychologie, den sogenannten Falschinformationseffekt, der insofern Falschinformationen noch gefährlicher macht: Dass diese falschen Informationen, wenn man sie einmal gehört und angenommen hat, für den Moment, wenn sie noch nicht korrigiert sind, dass diese Falschinformationen sehr stark im Gedächtnis verhaftet bleiben, und wenn mir später jemand sagt, das war so nie geäußert worden, hätte ich Schwierigkeiten, das wieder zu überschreiben."

Bleibt die Frage, welchen Schaden das anrichtet. Zerstört es unser Vertrauen in übermittelte Sprache? Oder den Glauben an die Existenz des Säbelzahntigers?

"Man würde in dem Fall ja nicht notwendigerweise das Vertrauen in die Person verlieren. Aber wir werden natürlich generell misstrauischer in alles, was uns medial vermittelt erreicht. Es wird sicherlich nicht so weit gehen, dass ich meinen eigenen Augen und Ohren nicht traue, wenn ich mich ganz normal in der realen Welt bewege."

Gibt es schon den erfolgreichen Fake mit synthetischem Audio, der das betrügerische Potenzial zeigt? Auf einen treffe ich immer wieder. Das wirkt, als gebe es nicht viel mehr. In dem Fall hatte ein Mitarbeiter einer Firma Geld an Betrüger überwiesen. Sie hatten ihm diesen Auftrag gegeben – scheinbar mit der Stimme des Chefs. Ein Beispiel, von dem mir auch Maria Pawelec erzählt:

"Wobei es natürlich im Nachhinein schwierig ist einzusehen, ob das wirklich ein synthetischer Audio-Deepfake war oder ob das vielleicht einfach ein Schauspieler gewesen ist."

Maria Pawelec und ihre Kollegin Cora Bieß, wissenschaftliche Mitarbeiterinnen der Uni Tübingen, untersuchen ethische Aspekte technischer Innovationen, auch Deepfakes.

"Wir denken schon, dass so etwas in Zukunft öfter mal vorkommen kann. Und auch, dass die Stimmen nahestehender Personen nachgestellt werden."

Synthetische Stimmen helfen Kranken und Behinderten

Trotzdem sollte ich vielleicht nicht nur dem Drang nachgeben, Technisches skeptisch zu beäugen und den Betrug zu suchen. Es gibt neben den praktischen kommerziellen Anwendungen ja auch interessante Visionen für perfekt geklonte Stimmen.

"Audio Deepfakes könnten Menschen helfen, die aufgrund von Behinderungen oder chronischen Erkrankungen ihre Stimme verlieren, eine authentische Stimme zur Kommunikation zu erhalten oder sogar ihre eigene Stimme gewissermaßen zu behalten", betont Cora Bieß.

Maria Pawelec ergänzt: "Was wir auch schon gefunden haben, ist beispielsweise ein Versuch, die Rede, die Richard Nixon gehalten hätte, wenn die Mondlandung misslungen wäre, in seiner Stimme sozusagen lesen zu lassen. Also, da sehen wir auch großes Potenzial von Deepfakes, gerade im Bereich Bildungsarbeit oder auch Museumspädagogik."

Aber auch das Feilen an künstlichen Stimmen ohne betrügerische Absicht kann fragliche Züge annehmen. In Südkorea gab es ein aufwendiges Experiment: Eine Mutter trifft in einer Virtual-Reality-Erfahrung ihre einige Jahre zuvor verstorbene kleine Tochter wieder.

Über Monate rekonstruiert aus Video, Bild und Tonmaterial. Die Tochter sieht so aus und spricht so, wie die Mutter sie kennt.

Gibt es künftig Kriegserklärungen per Deepfake?

Als ich das Video sehe, in dem die Mutter hinter der VR-Brille weinend ins Leere greift, die Tochter berühren will, finde ich das mehr als fragwürdig.

Was wäre denn, wenn ein Land im Fake-Video überzeugend einem anderen Land den Krieg erklärt? Was, wenn eine falsche Nachricht die Börsen crashen lässt? Menschen auf die Straße treibt?

"Selbst wenn man dazu kommt, dass die Situation im Moment noch nicht so dramatisch ist, weil die Technik noch nicht so weit ist, weil das noch nicht so verbreitet ist, sollte uns das nicht dran hindern, über die möglichen Konsequenzen nachzudenken", meint Jan-Hinrik Schmidt vom Leibniz-Institut für Medienforschung. "Dann fällt es uns als Gesellschaft auch leichter, gegenzusteuern, wenn es sich wirklich mal noch weiter durchsetzen sollte."

Selbst wenn die eine große Deepfake Geschichte bislang ausgeblieben ist – es nagt an der Demokratie und an einer wichtigen demokratischen Säule: wahrhaftiger Kommunikation.

"Wir erwarten auch mit Recht, dass in den öffentlichen Debatten zu politischen Themen, aber auch sonst, Menschen unter anderem auch wahrhaftig kommunizieren. Das heißt, dass sie andere Menschen nicht täuschen. Das ist eine Erwartung, die wird nicht immer erfüllt. Und wenn sich das durchsetzt oder wenn das vorkommt, erodiert das einen dieser Grundpfeiler, auf dem unser gesamtes demokratisches Verständnis von öffentlichen Debatten beruht."

Demokratieverdrossenheit als mögliche Folge

Maria Pawelec meint: "Im Prinzip ein Paradoxon ist, dass natürlich einerseits gerade mehr Bewusstsein über das Thema Deepfakes nötig ist, andererseits das aber auch etwas befeuert, was in der Wissenschaft die 'Lügner*innen-Dividende' genannt wird. Also dass sozusagen ein Klima entsteht, in dem man das Gefühl bekommt, dass man überhaupt nichts mehr glauben kann, was man sieht, was die Demokratie grundsätzlich bedroht und auch zu einem Vertrauensverlust und Demokratieverdrossenheit führen könnte. Und auch, dass Personen, die wegen bestimmter Äußerungen oder Handlungen in der Kritik stehen, zunehmend einfach behaupten können, dass eine bestimmte Datei ein Deepfake wäre."

Das meiste, was an Video-Deepfakes unterwegs ist, ist weniger Fake-Politisches, sondern mehr Fake-Pornografisches. Es muss ja aber nicht immer gleich ein Krieg sein, der die Demokratie gefährdet.

"Das sind Dinge in dem Maße, wie diese Technologien auch voranschreiten und leichter verfügbar werden", sagt Jan-Hinrik Schmidt. "In dem Moment wird diese Art der Manipulation demokratisiert. Bildlich gesprochen, und das kann bedeuten, dass es eben auch im zwischenmenschlichen Bereich eingesetzt wird. Das ist natürlich problematisch, weil das auch auf einer kleineren Ebene zwischenmenschliches Vertrauen zerstören kann. Letztlich ja, weil das dann das gedeihliche Zusammenleben zerstört."

Die Erstausstrahlung des Features war am 3. Dezember 2020.

Autor: Julius Stucke

Sprecher: Julius Stucke und Karim Cherif

Regie: Friederike Wigger

Technik: Ralf Perz

Redaktion: Martin Mair