Wir haben gerade eine breite Diskussion über diese Agency- und Autonomie-Sachen. Die verschleiert aber, dass wir eigentlich über Datenschutz oder über ökonomische Steuerungsprozesse reden müssten.

Gemeinwohlorientierte KI

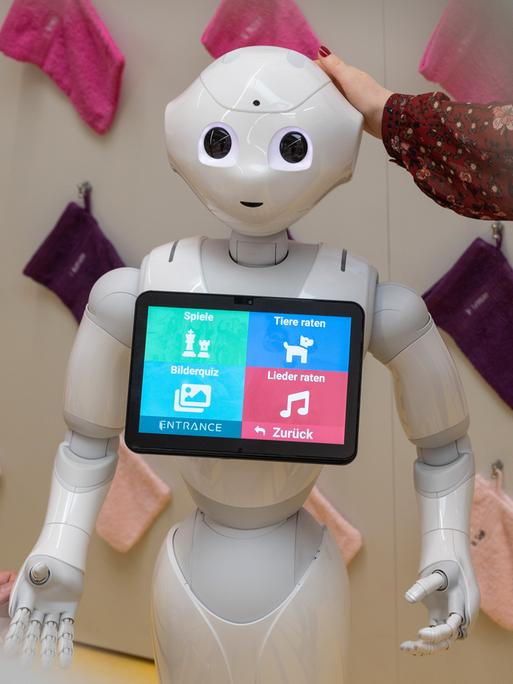

KI zum Wohl der Gesellschaft: Was künstliche Intelligenz für soziale Belange leisten kann, wird intensiv erforscht. © Getty Images / iStockphoto / Flashvector

Wie künstliche Intelligenz der Gesellschaft dienen kann

08:52 Minuten

Lernende Computersysteme können dem Gemeinwohl dienen. Kirchen, Sozialträger und Wissenschaft untersuchen, wie dies mit künstlicher Intelligenz gelingen kann. Dabei geht es nicht darum, menschliches Engagement zu ersetzen, sondern es zu unterstützen.

Künstliche Intelligenz – schon der Begriff ist schwierig. Oder genauer: Er illustriert, warum die menschliche Gesellschaft sich so schwer damit tut, einen sinnvollen Umgang mit lernenden Systemen zu finden, sagt die Theologin Frederike van Oorschot. Sie beschäftigt sich bei der Forschungsstätte der Evangelischen Studiengemeinschaft in Heidelberg mit ethischen Fragen im Zusammenhang mit künstlicher Intelligenz.

Konkrete ethische Fragen

"Was ist eigentlich Handlung? Was ist eigentlich Freiheit? An welchen Stellen beginnt Subjektivität?" Solche Fragen würden im Hinblick auf Maschinen oder maschinelle Prozesse diskutiert, doch häufig geschehe dies "erstaunlich abgekoppelt von dem, was die technologische Entwicklung tatsächlich leistet", beobachtet Frederike van Oorschot.

Die technische Entwicklung im Blick: Ethische Fragen sollten dort ansetzen, wo KI unser Leben konkret verändert, sagt Frederike van Oorschot.© privat

"Man hat es da mit der Übertragung von anthropologischen Fragen auf maschinelle Prozesse zu tun, die sich eben über den Begriff nahelegen, nicht unbedingt über die zugrunde liegende Technik." Deshalb findet van Oorschot: Die zentralen ethischen Fragen, die sich stellen, sind viel konkreter als eine eventuell einmal drohende "Ablösung des Menschen durch die KI".

Künstliche Intelligenz – vielleicht ist das einfach das falsche Label, vor allem, wenn es um den Einsatz fürs Gemeinwohl geht. Denn da gibt es praktische Möglichkeiten, die viel kleiner und vor allem viel handhabbarer sind als die Entwicklung einer gottähnlichen Maschine.

Bessere Beratung dank lernender Software

Ein Video-Clip, in dem der deutsche Caritas-Verband sein Pilotprojekt "Lernende Systeme in der Beratung" vorstellt, zeigt, am Beispiel einer Migrationsberaterin, wie künstliche Intelligenz dabei helfen kann, die Fachexpertise im Netzwerk einer großen Institution zu nutzen.

Projektleiterin Angela Berger erklärt: "Die KI findet heraus, wer die richtige Ansprechperson für meine konkrete Fachfrage in der Beratung ist, weil diese Person schon Erfahrungen mit ähnlichen Fällen gesammelt hat."

Und das funktioniere über die persönlichen Kontakte im Kollegenkreis hinaus, so Berger – sehr sinnvoll bei einem so großen sozialen Träger wie der Caritas. Man habe beim Pilotprojekt zu künstlicher Intelligenz auch aus einem weiteren Grund bei der Beratungsarbeit angefangen: Dort werden die notwendigen Daten schon deswegen erzeugt, weil vieles aus dem Beratungsgeschehen sowieso dokumentiert werden muss, sagt Berger.

Der kurze Weg zur Expertise: Angela Berger erprobt bei der Caritas zusammen mit Johannes Landstorfer den Einsatz von KI in der Beratung.© privat

Kein Mehraufwand für die Beratenden – das war eine der Vorgaben, unter denen das Lern- und Übungsprojekt entwickelt wurde. Angela Berger verrät, inwiefern "Lernende Systeme in der Beratung" mehr leistet als eine gehobene Suchanfrage.

Zugriff auf passende Profile

„Es gibt drei Stellen, wo das System auf jeden Fall intelligent ist“, sagt Berger: „Das ist zum einen da, wo aus einer Jahresstatistik automatisiert ein Expertiseprofil erstellt wird. Das ist zum Zweiten die Stelle, wo aus einer Frage, die am Anfang von Nutzer*innen eingegeben wird, ein sogenanntes Anfrageprofil gemacht wird. Und das ist drittens die Stelle, wo das Anfrageprofil und das Expertiseprofil miteinander verglichen werden, um dann wiederum das perfekte Matching hinzubekommen.“

Natürlich hat sich die Caritas schon länger mit dem Thema künstliche Intellligenz beschäftigt, aber eben oft unter dem Aspekt der ethischen Einordnung und des Menschenbildes und weniger unter der Perspektive: Könnten wir das auch bei uns einsetzen? Was könnte uns das bringen? Wie fühlt sich das überhaupt an, so was zu machen?

Eine Erkenntnis aus dem Testlauf mit der künstlichen Intelligenz: Solche Systeme müssen nicht notwendig auffällig oder spektakulär sein, sondern können gut im Hintergrund arbeiten, erklärt Johannes Landstorfer, der bei der Caritas für die digitale Strategie zuständig ist.

Computer sollen Beratende nicht ersetzen

„Wir hatten am Anfang Ideen, das ist ja so der Klassiker, der einem in der Beratung einfällt, dass so ein Chatbot direkt in Kontakt mit den Ratsuchenden ist. Das wird an vielen Stellen auch weiter untersucht und entwickelt, das will ich auch gar nicht ganz verwerfen“, sagt Landstorfer.

Und weiter: „Es war für uns nur klar: Wenn wir anfangen wollen mit so was, dann ist das der schwierigste Teil. Das haben uns auch die Beratenden gesagt, weil die Leute mit einem großen Bündel an Problemen kommen: Die haben komplexe Problemlagen. Das alles macht es dann recht hochschwellig und das ist nicht, wie wir Beratung anbieten wollen.“

Und außerdem wollten die Beraterinnen und Berater ja genau das: Hilfe suchende Menschen beraten. Lernende Computersysteme sollten das unterstützen, nicht ersetzen.

Verantwortung tragen können nur Menschen: Theresa Züger warnt davor, von intelligenten Systemen zu viel zu erwarten.© privat

Vielleicht ist das eine der wichtigsten Aufgaben beim Umgang mit dem, was unter den Sammelbegriff "künstliche Intelligenz" gefasst wird: genau festzulegen, für welches Problem sie eigentlich eingesetzt werden soll.

Manchmal ist die beste Lösung analog

Theresa Züger, die am Humboldt-Institut für Internet und Gesellschaft zu gemeinwohlorientierter KI forscht, erklärt, um welche Fragen es dabei geht. „Ist der Einsatz dieses Systems wirklich die beste Lösung für ein gesellschaftliches Anliegen? Gibt es eine Rechtfertigung für dieses System? In vielen Fällen kann man sagen: Nein“, sagt sie.

Denn: „In vielen Fällen gibt es möglicherweise eine viel einfachere technische Lösung, die das Problem genauso lösen könnte, oder eine komplett untechnische Lösung. Weil wir zum Beispiel entscheiden, dass bestimmte Bereiche der Pflege oder bestimmte Bereiche der Beratung oder bestimmte andere gesellschaftliche Entscheidungsbereiche Menschen vorbehalten bleiben sollen.“

Das öffentlich geförderte KI-Innovationsnetz "Civic Coding" hat 2022 einen Forschungsbericht über die Chancen und Risiken gemeinwohlorientierter künstlicher Intelligenz vorgestellt, an dem Theresa Züger mitgearbeitet hat. Zu dem Programm gehört auch ein Ideenwettbewerb, der noch bis zum 26. Januar 2023 läuft.

Der Einsatz von künstlicher Intelligenz ist vor allem eine gesellschaftliche Frage, keine technische, sagt Züger. Der Einsatz von künstlicher Intelligenz für gesellschaftlichen Nutzen ist noch ein ziemliches Nischenthema. Die Entwicklung von KI liegt vor allem bei den großen Techkonzernen, konzentriert sich auf Bereiche wie Werbung, Verkehr und Waffentechnologie.

Abschied von Allmachtsfantasien

Von dort kommt man dann schnell in die Bereiche der Allmachtfantasien, die die Theologin Frederike van Oorschot beim Nachdenken über die ethischen Konsequenzen eher für hinderlich hält.

Es ist ja nicht so, dass unser Gottesverständnis von Allmacht oder Allwissenheit ein technischer Automatismus ist, der alles weiß, dann rechnet und am Ende kriegt man die Quittung – und das ist das jüngste Gericht.

Künstliche Intelligenz fußt auf Algorithmen und Mustererkennung. Menschliches Verhalten ist anders, unschärfer, sagt Oorschot: "Vielleicht sind diese Unschärfen ja genau das, was uns als Menschen ausmacht."

Und Theresa Züger gibt zu bedenken: "Ich glaube schon, dass es eine Verführung für uns gibt. Dass so ein System, was erst mal eine Neutralität vortäuscht und auch eine Fehlerfreiheit vortäuscht, uns verführt, bei einer schwierigen Entscheidung zu sagen: Ich tendiere eher dazu, zu sagen, was die Maschine sagt. Das ist eine Gefahr, mit der wir uns auseinandersetzen müssen, dass dieser Bias, der Maschine zu glauben, irgendwo existiert."

Verantwortlicher Einsatz von KI

Wegen dieses Bias, dieser Vorannahme, plädiert Theresa Züger als Medien- und Politikwissenschaftlerin ganz energisch für eine zentrale menschliche Fähigkeit im Umgang mit künstlicher Intelligenz: für die Verantwortung.

„Verantwortung kann zwar ausgelagert werden, fällt aber letztlich immer wieder auf Menschen zurück. Deswegen gibt es keine echte Verlagerung der Verantwortung, sondern wir entscheiden letztlich auch, welche Systeme wir einsetzen. Und damit verschleiern wir vielleicht, wer im letzten Moment die Entscheidungen trifft, aber Verantwortung ist etwas, was nur Menschen tragen können“, sagt sie.

Künstliche Intelligenz braucht Daten, ohne die funktioniert sie nicht. Wie diese Daten entstehen, wer zu ihnen Zugang hat und auf welche Problemlagen sie angewendet werden – all diese Fragen müssen bei der Entwicklung von lernenden Systemen beantwortet werden.

Was die Diskussion über ethische Fragen dabei schon jetzt zeigt: Es wäre gut, wenn die Orientierung am Gemeinwohl einen größeren Stellenwert bekommt, und zwar auf jeder Ebene der Forschung zu künstlicher Intelligenz.