Können Maschinen bald unsere Gedanken lesen?

Die Gedanken sind frei - ist das demnächst Vergangenheit? Forscher können mit Hilfe von Computern bereits einzelne Absichten und Wahrnehmungen erkennen. Bislang allerdings nur sehr eingeschränkt. Doch die Algorithmen, die unsere Hirnsignale entschlüsseln, werden immer besser.

Zitat* (aus Jürgen Domians Roman "Der Gedankenleser"; weitere Zitate ebd.; s.u.): "'Wie er aus dem Mund stinkt. Ekelhaft. Aber dem Himmel sei Dank: Er macht die Augen auf. Er hat's überlebt. Wäre er abgekratzt…' Das waren die ersten Gedanken eines anderen Menschen, die in mich eindrangen. Zu jenem Zeitpunkt aber wusste ich überhaupt nicht, was mit mir geschah."

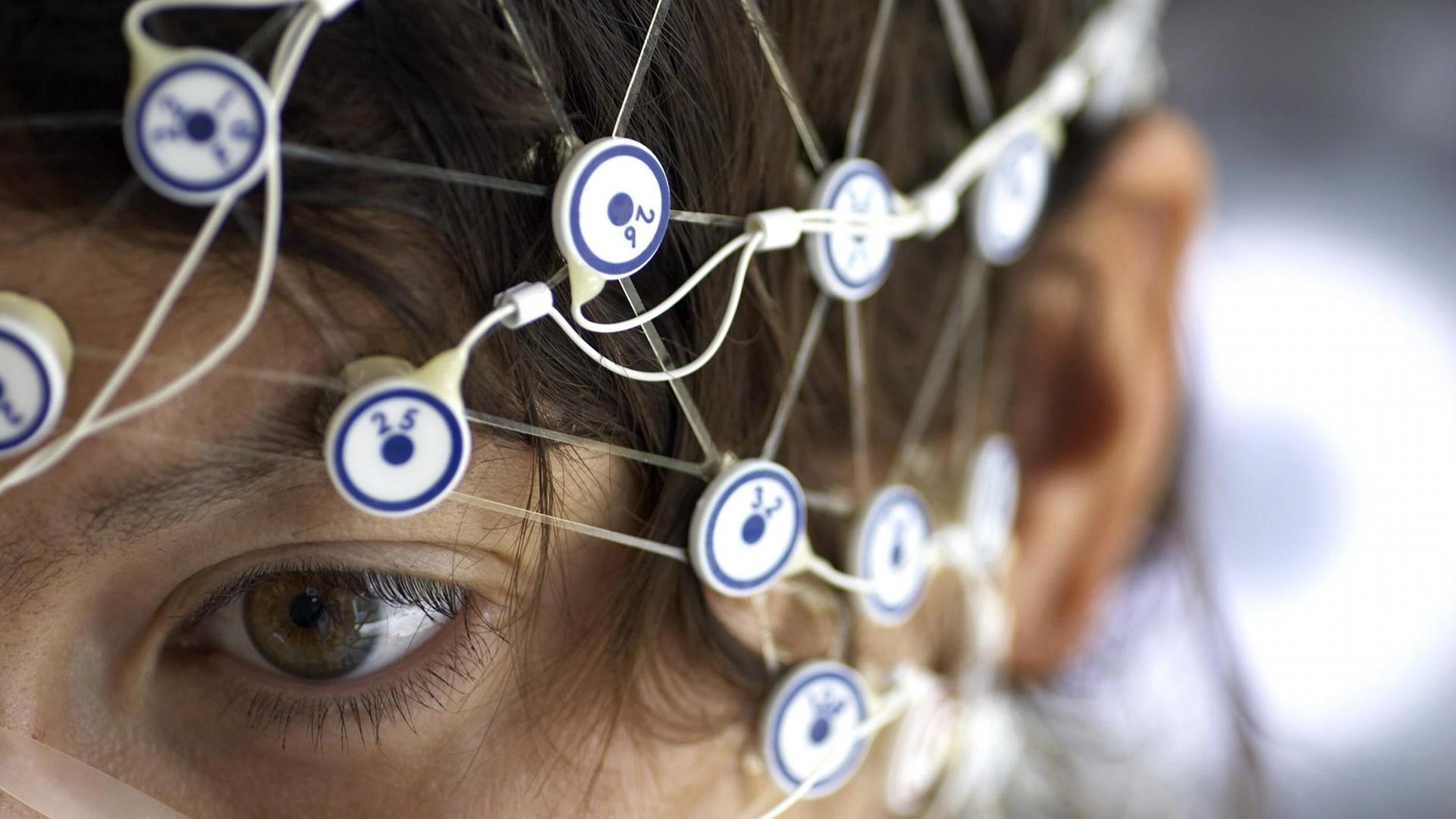

Ein Labor an der Technischen Universität Berlin. In dem rund 20 Quadratmeter großen Raum befinden sich ein Tisch, ein Computer und ein blaugepolsterter Lehnstuhl. Neurowissenschaftlerin Manon Grube steht vor dem Stuhl, in dem ein junger Mann als Versuchsperson sitzt. Sie greift in eine Kiste, holt eine handvoll Kabel und eine Kappe heraus.

"So, wir beginnen jetzt hier mit dem Experiment, mit dem EEG-Experiment. Der Proband, die Probandin bekommt die EEG-Kappe aufgesetzt. Die sieht aus wie eine Badekappe, wird hier so schön umgebunden, damit die dann auch festsitzt unter dem Kinn."

Die Neurowissenschaftlerin setzt dem Probanden die gummiartige Kappe auf den Kopf. In der Kappe befinden sich 64 kleine Löcher. In ihnen werden die Elektroden des EEG befestigt, des Elektroenzephalogramms. Mit den Elektroden lassen sich die Spannungsschwankungen auf der Kopfoberfläche messen, die bei jeder geistigen Aktivität entstehen. Manon Grube rückt die EEG-Kappe auf dem Kopf des Probanden zurecht.

"Okay, wunderbar. So, jetzt sitzt die schön fest. Und wir messen jetzt noch ganz genau mit dem Maßband, dass die Kappe genau mittig sitzt, zwischen den Ohren. Und dass die Kappe in Anführungszeichen mittig nach vorne und hinten hin sitzt."

Anschließend schmiert sie ein transparentes Gel in jedes der 64 Löcher der Kappe und befestigt so die Elektroden.

"Also ich trage jetzt hier das EEG-Gel auf, Elektrode für Elektrode. Und raue gleichzeitig mit einem Wattestäbchen ganz vorsichtig die Kopfhaut zwischen den Haaren ein bisschen an. Und dann sehen wir da drüben auf dem Bildschirm, wie Stück für Stück die Widerstände für jede einzelne der 64 Elektroden runter gehen."

Elektrode für Elektrode sinkt der Widerstand – dank aufgerauter Kopfhaut und elektrisch leitendem Gel. Auf dem Bildschirm des Computers, der die Daten der EEG-Kappe verarbeitet, wird der Widerstand für jede einzelne Elektrode angezeigt. Rund eine halbe Stunde dauert es, dann ist die Kappe präpariert – das Gedankenlesen kann beginnen.

Die Forscher messen die Spannungsschwankungen auf der Kopfhaut, die entstehen, wenn der Proband an eine Aufgabe denkt, ihre Umsetzung plant, Gerüche oder Geräusche wahrnimmt.

Wenn wir denken, werden elektrische Signale im Gehirn weitergeleitet. Die Spannungsschwankungen sind allerdings extrem schwach – und die Messungen daher eine enorme Herausforderung, sagt der Berliner Professor für Neurotechnologie Benjamin Blankertz.

"Die Nervenzellen im Gehirn arbeiten über elektrische Ströme. Und da ist es erst mal sehr schwierig, an der Kopfhaut an Informationen ranzukommen, weil es Milliarden von Nervenzellen im Gehirn gibt, die zu unterschiedlichen Zeiten dann feuern, das heißt elektrische Potenziale übertragen. Und an der Kopfhaut kann man das nur messen, wenn ganz große Gruppen von Neuronen mehr oder weniger im Gleichtakt feuern, sagen wir mal, eine Millionen Neuronen feuert gleichzeitig, dann addiert sich das so auf, dass man es auch an der Kopfhaut messen kann."

Mittels dieser Technik und dank hochgenauer Algorithmen, die die Messdaten von der Kopfoberfläche analysieren, lassen sich bereits heute verschiedene gedankliche Absichten erkennen – und in Befehle umsetzen. Ein virtueller Ball etwa kann auf einem Computermonitor von rechts nach links gerollt werden - allein durch Vorstellungskraft. Der Proband sitzt dafür ruhig in einem Sessel und stellt sich vor, seine linke Hand zu bewegen. Das Hirn ist dann elektrisch stark aktiv. Klaus-Robert Müller, Professor für Maschinelles Lernen an der TU Berlin, verdeutlicht das an einem Beispiel:

"Wir sitzen ganz bequem und entspannt da. Konzentrieren uns darauf zum Beispiel, in unserem Geiste unsere linke Hand einen Ball drücken zu lassen. Und diese Imagination der linken Hand wird repräsentiert über den Motorkortex auf der rechten Hemisphäre und da gibt es eine oszillatorische Aktivität."

Die Elektroden auf der Kopfhaut messen diese elektrische Aktivität im Motorkortex, der Steuerzentrale für Bewegungen. Eine Software analysiert das entsprechende Muster und löst einen Computerbefehl aus: Der Ball auf dem Monitor rollt also etwa nach links.

Neuronales Cocktailproblem

Zitat*: "Der Blitz hatte mich zwar nicht getötet, aber die unvorstellbare Kraft der Elektrizität, die meinem Gehirn so nahe gekommen war, hatte mich zu etwas befähigt, was sowohl Faszinosum als auch Fluch bedeuten sollte: Ich konnte Gedanken lesen."

Im Labor klappen diese Experimente, die unsere gedanklichen Absichten lesen, bereits erstaunlich gut. Mittlerweile werden sie auch in alltäglichen Umgebungen erprobt. Thorsten Zander vom Fachgebiet Biopsychologie der TU Berlin hat solche Gehirn-Computer-Schnittstellen an Piloten getestet.

"Wir waren an der TU München, die einen sehr schönen Flugsimulator haben. In den wir dann erfahrene und weniger erfahrene Piloten gesetzt haben, die mit einem Elektroenzephalogramm ausgerüstet waren. Die hatten Elektroden auf der Kopfhaut. Und die Piloten haben dann Standard-Flugaufgaben erledigt, die sie kannten. Und hier war es aber neu, dass sie über vorgestellte Bewegungen der linken oder rechten Hand, das Flugzeug nach links oder rechts fliegen konnten. Also den Simulator nach links oder rechts steuern konnten."

Das Besondere an diesem Experiment: Die Piloten sind im Simulator zahlreichen Tönen, Geräuschen und Bildern ausgesetzt. Und: Die Situation weckt Gefühle und Gedanken in ihnen, wie in der echten Arbeitssituation. Das Gehirn ist daher - anders als bei Laborversuchen - sehr aktiv. Die elektrischen Signale für die vorgestellte Handbewegung werden so von zahlreichen anderen Signalen überlagert.

Die Forscher sprechen in diesem Zusammenhang vom neuronalen Cocktailpartyproblem: So wie auf einer Coktailparty dutzende Menschen durcheinander sprechen, so feuern im Gehirn tausende Neuronen auf einmal. Es entsteht ein Wust an Informationen, den die Algorithmen analysieren und nach Mustern absuchen müssen.

Um solche Fehler zu vermeiden, benötigen die Forscher hochgenaue Algorithmen: Mathematische Programme also, die große Datenmengen analysieren und auf wiederkehrende Muster hin untersuchen. Die Algorithmen erkennen, wenn sich die Piloten im Flugsimulator eine Handbewegung vorstellen, mit der sie die Maschine steuern wollen. Auch das Experiment von Thorsten Zander war mit so einer Gehirn-Computer-Schnittstelle ausgestattet:

"Wir haben sieben Probanden getestet, also sieben Piloten, die versucht haben, den Simulator zu steuern. Und die Hälfte, also drei der Piloten, konnte das Flugzeug überraschend gut steuern. Die hatten eine Kontrollgenauigkeit von ungefähr 95 Prozent. Drei weitere hatten gar keine Kontrolle über den Simulator und ein Pilot hatte mittelmäßige Kontrolle."

Im Ganzen ist die Fehlerquote zu hoch, um Flugzeuge tatsächlich per Gedankenkraft zu steuern. Doch solch ein Praxiseinsatz ist auch gar nicht erwünscht, räumt der Wissenschaftler ein. Den Wissenschaftlern, die sich heute mit Gehirn-Computer-Schnittstellen, kurz BCI für brain computer interface, beschäftigen, geht es vor allem darum zu prüfen, wie gut sich die Gedanken der Probanden erkennen lassen – auch dann, wenn sie nicht im Labor sitzen.

Gehirn-Computer-Schnittstellen können beim Locked-In-Syndrom helfen

Zitat*: "'Nun sitzen wir hier auf unserer Traum-Schaukel… - und alles könnte perfekt sein. Aber er langweilt mich so. Immer dieselben Gespräche, immer dieselben Meinungen. Wie öde (…).' Diese Gedanken meiner Frau Anna über mich, ihren langjährigen Ehemann, waren im doppelten Sinne ein Schlüsselerlebnis für mich. Denn nach diesen wenigen Sätzen begriff ich schlagartig, was wirklich mit mir los war, welche Fähigkeit ich besaß (…)"

BCI-Systeme sind heute vor allem Gegenstand der Grundlagenforschung. Praktisch hilfreich kann die Technik dennoch sein, glaubt Thorsten Zander:

"Die klassische BCI-Forschung fokussiert sich darauf, neue Kommunikationskanäle für schwer behinderte Menschen zu ermöglichen. Es gibt leider Krankheiten, die Menschen in ihrem Körper einschließt, das so genannte Locked-in-Syndrom. Das heißt, die Menschen sind bei vollem Bewusstsein, können aber überhaupt nicht mehr mit der Außenwelt kommunizieren, auch nicht über kleinste Muskelbewegungen."

Eine Gruppe um Professor Klaus-Robert Müller von der TU Berlin hat Patienten mit der Amyotrophen Lateralsklerose zu Hause besucht. Die Patienten, die wegen ihrer degenerativen Muskelerkrankung weder sprechen noch sich bewegen können, bekamen EEG-Kappen aufgesetzt. Über vorgestellte Handbewegungen sollten sie dann einen Computer steuern.

"Eine Aufgabe in dem Experiment war zum Beispiel, Buchstaben zu kopieren. Also das heißt, es wird ein Buchstabe angegeben, zum Beispiel ein B, und dann hat der Proband ja die Möglichkeit, immer zwei Alternativen zu wählen. Und wir haben ein Interface, was es eben erlaubt, möglichst schnell Buchstaben auszuwählen."

Ein auf dem Monitor erscheinender Buchstabe ließ sich über die vorgestellte Handbewegung auswählen oder verwerfen. Nach und nach konnten die Patienten so einzelne Buchstaben per Gedankenkraft zu ganzen Worten auf dem Monitor zusammenfügen. Für sie ist es eine Möglichkeit, mit ihrer Umwelt zu kommunizieren. Doch der Prozess ist langwierig – und nicht bei allen Patienten erfolgreich, bilanziert Klaus-Robert Müller das Experiment:

"Wie immer ist das Ergebnis gemischt. Es gibt Patienten, denen geht es noch zu gut, als das das Brain-Computer-Interface wirklich was helfen könnte. Und es gibt auch Patienten, die in dem Stadium sind, wo das Brain-Computer-Interface ihnen wirklich helfen kann. Also in unserem Fall gab es einen Patienten, der mit dem Brain-Computer-Interface auf Grund seiner individuellen Disposition und seinem Krankheitsbild jetzt wirklich schneller kommunizieren konnte."

Für ihr Experiment haben die Forscher vier Patienten untersucht. Repräsentativ ist das Ergebnis daher nicht. Doch es zeigt einen Trend: Die entwickelten Algorithmen können die Absichten der Patienten schon recht gut detektieren – selbst wenn diese erkrankt sind.

Auch gelähmte Menschen könnten profitieren

Hirnsignale – egal, wie die aussehen – können heute durch Algorithmen erkannt werden. Die Computer detektieren dafür wiederkehrende Muster. Maschinelles Lernen nennt sich das Verfahren. In früheren Experimenten mussten die Patienten lernen, ihre Hirnsignale zu modifizieren – durch langwieriges Biofeedback-Training am Bildschirm. Das ist nicht mehr nötig.

"Üblicherweise war, dass die Patienten ungefähr 50 Sessions mindestens gebraucht haben, um in eine Kommunikation mit dem Brain-Computer-Interface einsteigen zu können. Und die Patienten mussten sich sozusagen an die Software anpassen, die dekodiert hat. Wir haben das anders gemacht. Wir haben das maschinelle Lernen eingesetzt. Und haben die Patienten denken lassen was sie wollten und haben versucht, das zu dekodieren, mit Hilfe der maschinellen Lernalgorithmen."

Nach durchschnittlich fünf Trainingssitzungen konnten die Algorithmen die Absichten der Patienten erkennen, weil sie ein widerkehrendes Muster an elektrischer Spannung bilden. Bei gesunden Menschen geht dieser Prozess noch schneller. Manche Probanden benötigen nicht einmal uehn Minuten, um Kontrolle über das BCI-System zu erlangen.

Und die Mustererkennung ist heute schon so genau, dass sich die Absichten der gesunden Probanden auch dann erkennen lassen, wenn das Gehirn gleichzeitig zahlreiche weitere Sinneseindrücke verarbeitet. Zukünftig sollen außerdem möglichst alle Menschen BCI-System nutzen können. Ausfälle wie bei dem Pilotenexperiment, bei dem manche Versuchsteilnehmer das System nicht kontrollieren konnten, soll es dann nicht mehr geben. Denn dieser BCI-Analphabetismus ist in der Art der Steuerung begründet. Professor Benjamin Blankertz:

"Dass jeder dritte Proband Schwierigkeiten mit der BCI-Steuerung hat, das bezieht sich auf die Systeme, die mit vorgestellten Bewegungen funktionieren. Deswegen haben wir jetzt in letzter Zeit mehr BCI-Systeme untersucht, die mit visuellen oder akustischen Reizen arbeiten. Und da ist es bei gesunden Versuchspersonen so, dass die Quote quasi hundert Prozent mehr oder weniger ist, von denen, die es benutzen können. Aber das heißt nicht, dass sich das dann für die gelähmten Patienten überträgt. Da sind die Gehirnsignale deutlich anders und je stärker die Lähmung ist, desto untypischer sehen auch die Hirnsignale aus und je größer wird die Herausforderung, dann ein BCI-System zu machen, dass auch für sie funktioniert."

Bei den neuen BCI-Systemen wählen die Probanden beispielsweise Buchstaben nicht mehr aus, in dem sie sich Handbewegungen vorstellen. Stattdessen blinken die Buchstaben des Alphabets sukzessive auf dem Monitor auf. Blinkt etwa ein erwünschtes E, das man braucht, um ein spezielles Wort zu bilden, dann entsteht zeitgleich mit dem visuellen Reiz eine starke elektrische Aktivität im Gehirn. Das BCI-System erfasst das Signal – und wandelt es in einen Computerbefehl um. Buchstabe für Buchstabe können die Probanden so Wörter formen – allein kraft ihrer Gedanken. Und auch wenn das Verfahren bei gelähmten Menschen nicht die gleiche Erfolgsquote verspricht: Nützen könnte es auch ihnen.

"Was man bisher absehen kann, ist dass es einen relativ kleinen Kreis von Patienten gibt, für die das interessant ist und da ist im Moment gerade ein bisschen die Diskussion, dass die BCI-Systeme von den Krankenkassen bezahlt werden. Und dann denke ich, für schwerstgelähmte Patienten schon, dass das in den nächsten Jahren erst mal vereinzelt eingesetzt wird und dann muss man sehen, was für Erfahrungen damit gesammelt werden."

Gehirn ein Stück weit gläsern geworden

Zitat*: "Ich griff zu meinem Weinglas, das direkt neben der Schaukel auf einem kleinen Tisch stand, und trank ein wenig. 'Dieses Geräusch, wenn er schluckt, ich kann es nicht mehr hören, wie widerlich.' Ich setzte noch einmal an und trank das Glas ganz leer. 'Kein Mensch schluckt so ekelhaft.' Meine Hand zitterte, was Anna aber gar nicht bemerkte, und ich stellte das Glas zurück auf den Tisch."

Brain-Computer-Interfaces sind derzeit vor allem Gegenstand von Forschung und Entwicklung. Im Frühjahr 2015 haben mehrere europäische Universitäten und private Firmen die Roadmap Horizon 2020 zur BCI-Technik vorgelegt. In ihr skizzieren sie den Stand der Forschung – und sie zeigen mögliche Anwendungsgebiete.

Beteiligt war unter anderem die TU Berlin, eine Schweizer und eine niederländische Hochschule. Koordinator der Roadmap ist Professor Gernot Müller-Putz vom Lehrstuhl für semantische Datenanalyse der TU Graz.

"Die Europäische Kommission ist interessiert an dieser Forschung und möchte wissen von den jeweiligen Forschern, ob eine Zukunft für dieses Brain-Computer-Interface besteht, ob es sinnvoll ist, Förderung durchzuführen. Und wir wollten zeigen, wir wollen da weiterforschen, wir wollen das weitermachen. Weil wir tatsächlich eine Vision haben, wie dieses System in der Allgemeinheit verwendbar werden kann."

In der Vergangenheit hat die Europäische Kommission die Forschung zu Brain-Computer-Interfaces finanziell bereits kräftig unterstützt. Von ihrem siebten Rahmenprogramm, das von 2007 bis 2013 europäische Forschung und Technologie gefördert hat, konnte auch die BCI-Technikentwicklung profitieren. Mehre Millionen Euro wurden investiert.

"Im Horizon 2020 ist diese Förderung zurückgegangen, also im achten Rahmenprogramm. Und da spielt hoffentlich jetzt für die Zukunft unsere Roadmap eine Rolle, sodass die Kommission überzeugt werden kann, dass hier wieder die Förderung in den weiteren Calls, die noch folgen werden in diesem Rahmenprogramm, dass die wieder aufgenommen werden."

Die finanzielle Förderung der BCI-Forschung entscheidet maßgeblich über deren weiteren Verlauf. Nicht umsonst wirkt die Roadmap zur BCI-Technik teils wie eine Werbebroschüre: Der mögliche Nutzen für gelähmt Menschen wird herausgestrichen, Szenarien für die BCI-Technik in der Schlaganfall-Rehabilitation werden entworfen, ihr Nutzen als Forschungsinstrument gezeigt.

Tatsächlich kann die EEG-basierte BCI-Technik in der Grundlagenforschung nützlich sein. Am Deutschen Institut für Ernährungsforschung in Potsdam hat Kathrin Ohla das Geschmacksempfinden von Menschen untersucht.

Die Forscherin bat dafür 16 Probanden ins Labor. Sie setzen den Versuchspersonen EEG-Kappen auf, befestigten darauf Elektroden und schloss das System an einen Computer an. Jetzt träufelte sie den Probanden Geschmackslösungen auf die Zunge: Zum Beispiel saures oder süßes, salziges oder bitteres. Die Nervenzellen im Gehirn feuerten - und der Computeralgorithmus analysierte.

"Bei unserer EEG-Messung haben wir 64 Elektroden auf der Schädeloberfläche positioniert. Und wir wissen von jeder einzelnen Elektrode, wo sie sich befindet. Und wir messen über die Zeit, quasi in Millisekundenauflösung, wie das elektrische Signal im Gehirn an jeder dieser Elektroden generiert wird. Das gibt uns ein räumlich-zeitliches Muster. Und diese komplexen Muster, die hat ein Computeralgorithmus für uns analysiert und Unterschiedlichkeiten festgestellt."

Zwei Stunden lang saßen die Versuchspersonen im Labor, immer wieder bekamen sie Geschmackslösungen auf die Zunge geträufelt. Ihre Nervenzellen feuerten – und der Algorithmus analysierte und lernte. Kathrin Ohla:

"Bisher war es noch völlig unklar, ob wir im menschlichen Gehirn überhaupt zwischen verschiedenen Geschmäckern oder Geschmacksqualitäten unterscheiden können. Und wir haben herausgefunden, dass sich die räumlichen und zeitlichen Muster, die die Nervenzellen im Gehirn generieren, unterscheiden zwischen den verschiedenen Geschmackskategorien. So dass ein Computeralgorithmus diese Signale erkennen und unterscheiden kann."

Die Forscher fanden nicht nur heraus, das Geschmacksreize bereits nach 175 Millisekunden im Gehirn unterschieden werden – und damit sehr viel schneller als angenommen. Sie konnten auch belegen, dass etwa Süßes oder Saures unverwechselbare Muster im Gehirn erzeugen. Anhand dieser Muster war es den Forschern sogar möglich vorherzusagen, was die Probanden schmeckten. Ob eine Person etwa salzig oder bitter schmeckt, können die Forscher also erkennen – auch, wenn die Versuchsperson schweigt.

"Welche Gedanken sie nebenher dabei noch hatten, wie welche Termine auf sie am Abend warten, was denn noch eingekauft werden muss, solche Dinge können wir natürlich nicht herauslesen. Und das ist mir auch ganz wichtig, das zu sagen. Denn diese Gedanken bleiben auch weiterhin privat."

Gedankenlesen im strengen Sinne ist das nicht. Allerdings: Welche geschmackliche Wahrnehmung die Probanden haben, das können die Forscher erkennen. Das Gehirn und seine Prozesse sind damit ein Stück weit gläsern geworden.

Neue Anwendungen zeichnen sich bereits ab

Und zukünftig könnte es den BCI-Systemen sogar möglich sein, unsere Gefühle zu lesen. Denn Zustände wie starken Stress etwa können die Systeme bereits detektieren, sagt Thorsten Zander von der TU Berlin.

"Neben den kognitiven Zuständen, die gemessen werden können, wie Überraschungen oder Belastung oder so etwas in der Art, kann man theoretisch auch emotionale Zustände messen. Also Freude, Trauer oder so etwas in der Art. Das wird im Moment stark untersucht; und da gibt es auch ganz klare Hinweise, dass das bis zu einem gewissen Grad geht. Ob das jedoch so gut funktioniert, dass man es wirklich sinnvoll in einer Mensch-Computer-Interaktion anwenden kann - also dass der Computer eben wirklich verlässlich sieht, dass ich gerade sehr froh bin -, ist im Moment noch anzuzweifeln, also man weiß es nicht, da wird noch dran geforscht."

So eine Gefühlserkennung könnte etwa nützlich sein, um mit Robotern zu kommunizieren, ergänzt der Forscher. Doch ob es auch gesellschaftlich wünschenswert ist, unsere mentale Privatsphäre immer weiter zu entschlüsseln, ist mehr als fraglich. Denn die Erforschung unserer geistigen Prozesse ist eine sensible Angelegenheit.

Zitat*: "Eigentlich zerbrach unsere Ehe genau an diesem Sonntagnachmittag. So muss ich im Nachhinein sagen. Die Gedanken meiner Frau Anna, die ich auf der Hollywoodschaukel und später während unseres Spaziergangs gehört hatte, brachten unser vertrautes Leben zum Einsturz."

Neurowissenschaftlerin Kathrin Ohla:

"Mir liegt es auch besonders am Herzen, klarzustellen, dass es durchaus ein ethisches Problem ist, größere Mengen an Daten, auch so privaten Daten wie Hirninformationen, Hirnaktivitätsmuster zu sammeln, und dass man sehr sorgfältig mit diesen Daten umgehen muss. Und dass es auch das Einverständnis der Versuchsteilnehmer voraussetzt, was denn tatsächlich mit diesen Daten genau geschehen wird."

Die Forschung hält sich an diese Standards. Doch die Entwicklung von Gehirn-Computer-Schnittstellen schreitet stetig voran. Und so scheint es zumindest nicht unmöglich zu sein, dass solche Systeme irgendwann auch für andere Zwecke genutzt werden: etwa um die Gefühle, Gedanken und Absichten von Menschen zu überwachen. Auch wenn sich das derzeit technisch noch nicht machen lässt.

"Wir sind noch sehr weit davon entfernt, einfach Sensoren im freien Raum aufzustellen und die Gedanken von Passanten, die nicht wissen, wie ihnen geschieht, tatsächlich aufzufassen. Also da ist noch ein großer Unterschied zwischen dem Gedankenlesen, so wie wir es jetzt machen im Labor, das mit Einverständnis erfolgt, und dem, was gerade auch in der Datensammelwut in unserer Gesellschaft eigentlich passiert."

Thorsten Zander denkt allerdings auch nicht, dass sich solche universellen Gedankenlesegeräte in absehbarer Zeit überhaupt entwickeln ließen. Selbst dann nicht, wenn man es wollte.

"Mit dem EEG halte ich es im Moment für ausgeschlossen. Also ich glaube nicht, das wir spezifische Informationen über Gedanken, die jemand gerade formuliert oder denkt, zurückschließen können. Dazu ist das EEG zu ungenau und das Gehirn viel zu komplex. Jedoch denke ich auch, dass es mit anderen Maßen im Moment unter realistischen Bedingungen sehr schwer werden würde. Also ich habe persönlich keine Angst, dass ein Computer innerhalb der nächsten Jahrzehnte meine Gedanken lesen kann."

Abstrakte, sprachlich formulierte Gedanken werden mit der BCI-Technik auch in Zukunft nicht zu erkennen sein: In dieser Prognose sind sich die Forscher einig. Nützlich ist die Technik in absehbarer Zukunft vor allem für die Grundlagenforschung, und um Maschinen zu steuern. Neue Anwendungen, die auf Gehirn-Computer-Schnittstellen basieren, zeichnen sich bereits ab.

Gedanken lesen kann noch niemand

An der TU Graz wird derzeit ein Forschungsprojekt koordiniert, das die EU mit knapp 3,5 Millionen Euro fördert. "More Grasp" heißt das Projekt. Die Forscher wollen dabei eine Neuroprothese entwickeln: Sie soll es im Rollstuhl sitzenden Menschen ermöglichen, ihre gelähmten Hände wieder zu bewegen - allein durch Vorstellungskraft. Die Patienten stellen sich eine Handbewegung vor – und das BCI-System reagiert, erläutert Gernot Müller-Putz.

"Die Hirnsignale kommen in dem Steuercomputer im Rollstuhl an drahtlos und werden dort dann per Kabel an ein Stimulationsgerät geführt und das hat dann kleine, dünne Kabel, die dann zu den jeweiligen Positionen am Unterarm und am Oberarm führen, wo Elektroden aufgeklebt werden. Und diese Elektroden übertragen dann elektrische Strompulse auf die Haut und den darunter liegenden Nerv, der die Muskeln versorgt. Und dort findet dann die Stimulation statt und damit auch die Kontraktion, also das Anspannen der Muskeln zum entweder Öffnen der Hand oder zum Schließen der Hand."

Das BCI-System überbrückt also gewissermaßen das durchtrennte Nervensystem der Patienten: Stellen die sich vor, ihre Hand zu schließen, dann wird dieser Befehl elektronisch an die Nerven im Arm weitergeleitet. Die Nerven werden stimuliert – und die Handbewegung damit angebahnt, erläutert der Grazer Forscher.

"Das Aktionspotenzial vom Nerv geht an den Muskel, über die motorische Endplatte an den Muskel, und dann würde der Muskel dort kontrahieren."

Die Hand schließt sich. Künftig soll sich die Neuroprothese durch möglichst natürliche Gedanken steuern lassen. Die elektrischen Muster, die diese Gedanken auf der Kopfhaut erzeugen, müssten die Algorithmen dann allerdings auch erkennen können.

Ein wesentlicher Erfolg der BCI-Forschung liegt genau in dieser Datenanalayse. Die Algorithmen sind mittlerweile in der Lage, aus einem riesigen Informationswirrwarr feinste Muster herauszufiltern - also aus einer Vielzahl elektrischer Spannungen auf der Kopfhaut Muster zu detektieren. Zu erkennen ist dabei, dass etwa das Gehirn der Probanden im motorischen Cortex spezifisch aktiv ist. Nicht mehr, aber auch nicht weniger.

"Man kann sehen, es ist eine Aktivierung im Motorareal nahe der Hand, es ist Aktivierung in Nähe des Fußareals, aber was genau dort gedacht wurde, dass kann man nicht feststellen, also das ist wirklich zu grob das Ganze."

Ob der Proband also einen Stift nehmen und damit einen Brief schreiben will, bleibt den Forschern auch weiterhin verborgen. Ganz zu schweigen von dem Inhalt, den er mitteilen möchte. Denn davon, den Sinn von sprachlich gefassten, abstrakten Gedanken zu erfassen, sind die BCI-Systeme weit entfernt. Die meisten Forscher bezweifeln, dass so etwas überhaupt je möglich sein wird. Zumindest in diesem Sinne gilt bis auf weiteres: Die Gedanken sind frei – und auslesen kann sie noch niemand. Auch wenn unser Gehirn und seine Prozesse durch die BCI-Technik ein Stück weit gläsern geworden sind.

* ZITATE aus dem Roman: "Der Gedankenleser" von Jürgen Domian, erschienen im Wilhelm Heyne Verlag, München, 2010.