Sprachlosen Patienten eine Stimme geben

07:44 Minuten

Von Carina Fron · 08.08.2019

Menschen mit Locked-in-Syndrom sind in ihrem Körper gefangen. Sie können sich kaum bewegen und nicht sprechen. Forscher arbeiten daran, Gehirnströme dieser Patienten in Sprache zu übersetzen. Aber auch große Unternehmen haben Interesse an der Technologie.

Karl-Heinz Pantke fällt mit 39 Jahren auf einmal um. "Die Sanitäter haben mich dann erst einmal kurzerhand für tot erklärt", erzählt er.

Im März 1995 erleidet der Physiker einen Klein- und Stammhirninfarkt - eine besonders schwere Form des Schlaganfalls: "Und konnte mich natürlich überhaupt nicht mehr bewegen."

Den überleben die meisten nicht. Pantke schon: "Meine Lebensgefährtin fand mich dann. Ich lag wie tot auf meinem Bett."

"Immer mitten im Leben"

Dabei ist er die ganze Zeit bei klarem Verstand, kann sich weder bewegen, noch sprechen. Er leidet unter dem Locked-in-Syndrom. Er habe alles mitgekriegt, sei bei allem dabei gewesen, sagt Karl-Heinz Pantke: "Immer mitten im Leben."

Fast 25 Jahre später kann er Witze über diese Zeit machen. Doch er hat nicht vergessen, wie es ist, gefangen im eigenen Körper zu sein. Nach vier Tagen auf der Intensivstation konnte Karl-Heinz Pantke zumindest die Finger ein kleines bisschen bewegen.

"Wir mussten uns selbst was einfallen lassen", erinnert es sich. "Es gab als Hilfsmittel lediglich die Buchstabentafel." Das Sprechen fällt ihm heute noch schwer, einige Teile seines Körpers sind immer noch gelähmt. Andere haben sich erholt.

Karl-Heinz Pantke hilft mit dem Verein "Locked-In-Syndrom e.V." anderen Menschen.© dpicture alliance / dpa / Rolf Kremming

"Ich bin natürlich nicht der typische Patient mit einem Locked-in-Syndrom", sagt Karl-Heinz Pantke. "Weil ich kann vieles wieder bewegen, kann hier sitzen, aus dem Glas trinken und leckere Kekse essen."

Einzelne Buchstaben zu Wörtern zusammensetzen

Mit seinem Verein "Locked-in-Syndrom e.V." hilft Pantke anderen Menschen. Auch Patienten mit amyotropher Lateral-Sklerose, kurz ALS. Die können ebenfalls das Locked-in-Syndrom bekommen. Die Krankheit sorgt für Muskelschwund, am Ende können die meisten Patienten nur noch ihre Augen bewegen.

Mithilfe des sogenannten "EyeGaze-System" können sie sich verständigen: Die Augen fixieren hier einen Buchstaben auf einer Bildschirmtastatur. Eine Kamera verfolgt die Bewegungen, setzt die Wörter zusammen. Mit einem Gespräch ist das dennoch nicht zu vergleichen.

"Durch medizinische Verbesserungen leben Menschen zum Beispiel mit Locked-in-Syndrom auch länger als früher", sagt Tanja Schultz, "und da zählt wirklich jeder Tag. Also wenn man nicht kommunizieren kann, wenn man seine Wünsche nicht äußern kann, ich stell es mir entsetzlich vor."

Tanja Schultz arbeitet als Informatikerin an der Universität Bremen an einem System, das Gehirnaktivität in Sprache übersetzt.

"Die Idee ist nun, dass man diejenigen Hirnareale beobachtet, aus denen tatsächlich die Muskelinnervierungen ausgehen", erklärt sie. "Das sind die sogenannten Motorneuronen im Motorcortex. Und diese Motorneuronen werden dann innerviert, wenn man etwas aussprechen möchte. Und man nimmt an, dass sie auch dann innerviert werden, wenn man nur plant etwas zu sprechen."

Einfach ausgedrückt: Das Gehirn steuert die Gesichtsmuskulatur beim Sprechen. Diese Befehle werden auch dann gegeben, wenn man nicht sprechen kann. Um das System zu verbessern, arbeiten Schultz und ihr Team mit Epilepsie-Patienten. Ihnen werden Elektroden auf die Gehirnoberfläche transplantiert.

"Jetzt sieht man direkt auf der Cortextoberfläche einen Elektrodengrid", sagt Tanja Schultz. "Das sind hier ungefähr acht mal acht Elektroden."

Sprache aus der Gehirnaktivität herausfiltern

Damit wollen die Mediziner eigentlich den Teil bestimmen, der Anfälle auslöst. Um ihn herausschneiden zu können.

"Jede dieser Elektroden zeichnet im Wesentlichen die Aktivität der darunterliegenden Neuronenverbünde auf", erklärt die Informatikerin, "und weil zumindest grob auch bekannt ist, in welchen Arealen was passiert, kann man aus der Lokalität oder der Verortung dieser einzelnen Elektroden auch Rückschlüsse darauf ziehen, was da drunter passiert."

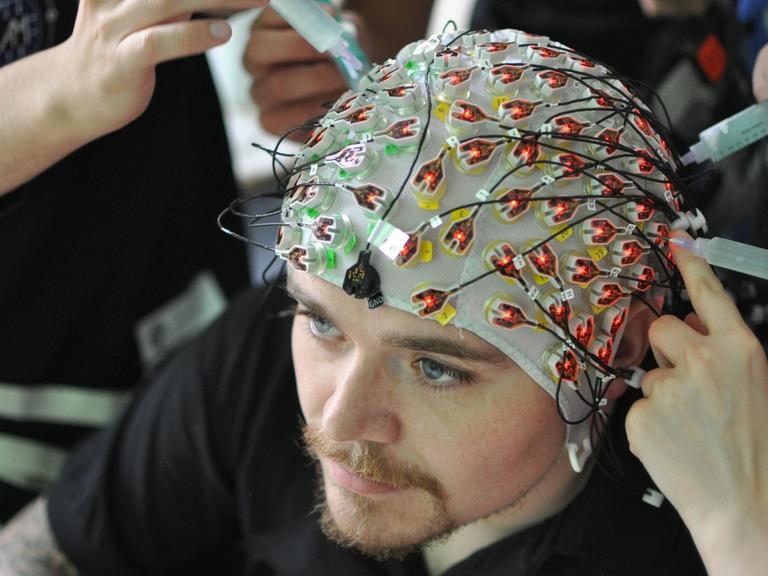

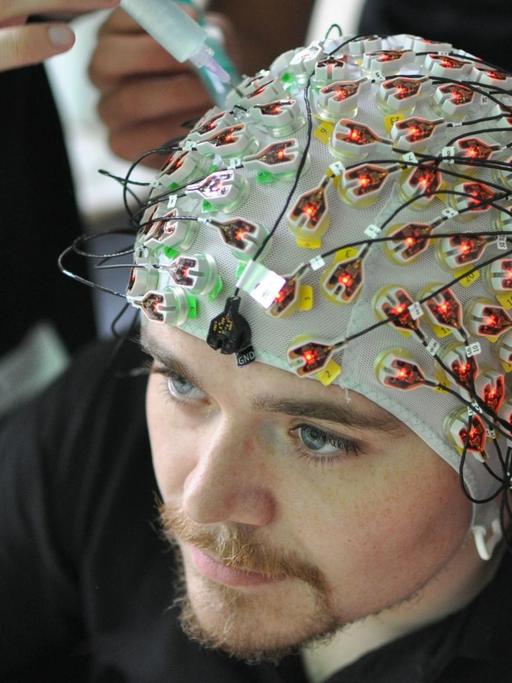

Kopfhauben mit Elektroden zur Messung von Hirnströmen© picture alliance / dpa / Jens Büttner

Die Aufnahmen zeigen, wie beim Sprechen welche Neuronen wie feuern. Übersetzer dieser Signale sind neuronale Netze, erklärt Christian Herff von der Maastricht Universität:

"Das erste neuronale Netz verwandelt die Gehirnaktivität in so eine spektrale Darstellung von Sprache und ist für jeden Patienten individuell trainiert, also für jeden Patienten und dessen spezielle Elektrodenposition berechnen wir, wie kann ich seine Gehirndaten oder ihre Gehirndaten in spektrale Darstellung von Sprache verwandeln."

Kein Gehirn gleicht dem anderen. Somit sitzen die Elektroden auf der Gehirnoberfläche auch nicht immer gleich. Ein zweites neuronales Netz wird mit hunderten Stunden Audiodateien von gesprochener Sprache trainiert und verwandelt die spektrale Darstellung in Sprache zum Hören.

Übersetzung der Gehirnsignale in Echtzeit?

"Also das erste Wort ist das, was man aus der akustischen Aufnahme entnommen hat", erklärt Tanja Schultz. "Und das zweite Wort, was man aus der Hirnaktivität generiert hat."

Eine Gruppe von der University of California in San Francisco hat gerade eine neue Studie bei "Nature" veröffentlicht. Der Titel: "Real-time decoding of question-and-answer speech dialogue using human cortical activity". Die Studie zeigt, wie sich das Ganze noch verbessern lässt. Hauptautor David Moses erklärt:

"Wir haben versucht mit Hilfe von Kontexten die Übersetzung der Gehirnsignale zu verbessern. In unserer Studie haben die Teilnehmer Fragen beantwortet. Und wir haben dann aus ihrer Gehirnaktivität einerseits entschlüsselt, welche Frage sie gerade gehört hatten. Und haben andererseits damit auch gleich unsere Übersetzung der Antwort verbessert."

Die Übersetzung der Signale wird gleich auf einem Bildschirm abgebildet. Bisher funktioniert es aber nur mit einer kleinen Anzahl von Fragen und Antworten. Der Ingenieur Moses ist aber zuversichtlich, will die Forschungsgruppe doch bald mit einem paralysierten Patienten arbeiten.

Finanzielle Unterstützung von Facebook Reality Labs

Unterstützt werden Moses und seine Kollegen bei ihrer Forschung unter anderem von Facebook Reality Labs, personell und finanziell: "Facebook Reality Labs hat anscheinend ein Interesse an nicht-invasiven Methoden. Sie finanzieren uns hauptsächlich um zu verstehen, wie Gehirnaktivtität in Sprache übersetzt wird."

Exklusive Daten würde Facebook Reality Labs aber nicht bekommen. Beunruhigend ist es aber trotzdem, hat der Konzern vor einigen Jahren bereits angekündigt, Gedanken lesen zu wollen - um zum Beispiel technische Geräte damit steuern zu können.

Unbestreitbar ist, dass diese Technologie ein echter Gewinn für alle Menschen sein kann, die nicht mehr sprechen können. Aber wem gehören die Informationen, die aus den Gehirndaten gelesen werden? Und wie kann man sicher sein, dass diese nicht missbraucht werden?