Warum Youtube eine Radikalisierungsmaschine ist

Matthias Spielkamp im Gespräch mit Ute Welty · 11.09.2018

Der Algorithmus von Youtube führt dazu, dass den Nutzern Videos mit radikalem Inhalt empfohlen werden, kritisiert Matthias Spielkamp von Algorithmwatch. Das betreffe sogar Kinder. Er fordert, Youtube solle Verantwortung übernehmen und Daten offenlegen.

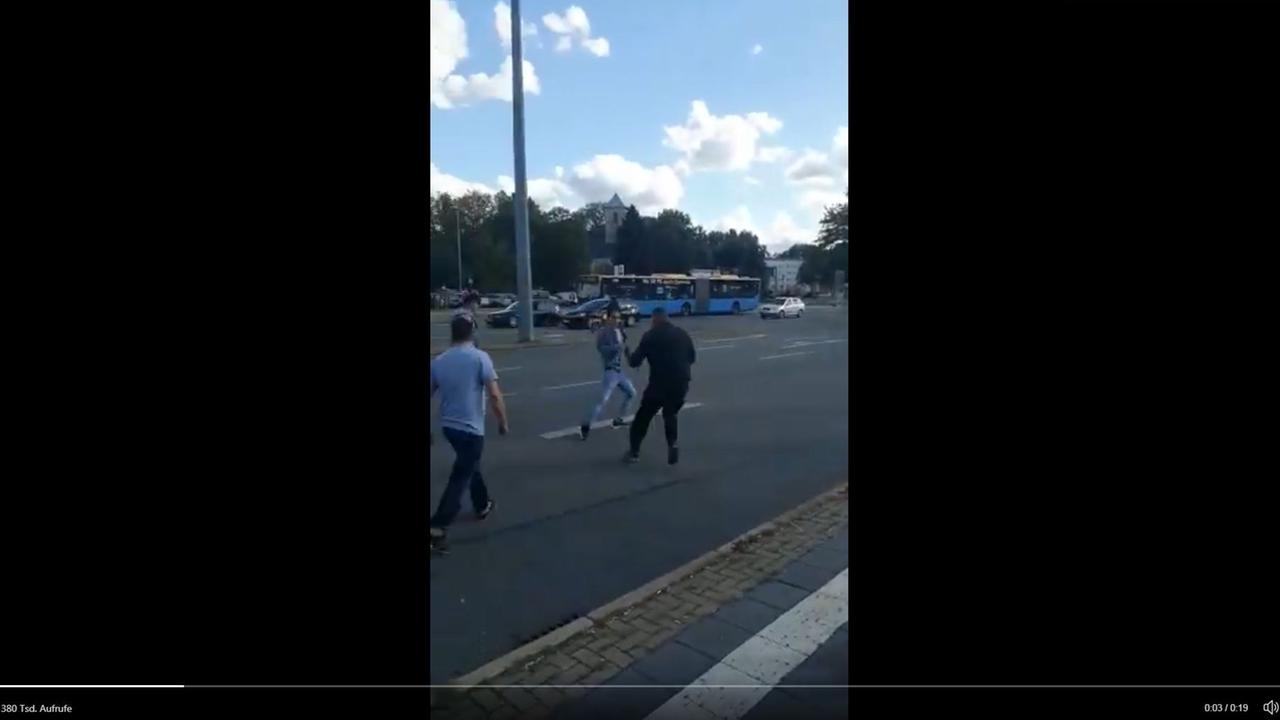

Ute Welty: Es ist eine arbeitsreiche Woche für Verfassungsschutzpräsident Maaßen, der sich mindestens drei Termine wahrscheinlich gern gespart hätte. Den mit seinem Chef, dem Bundesinnenminister, den mit dem Innenausschuss des Bundestages und den mit dem parlamentarische Kontrollgremium, das für die Kontrolle der Geheimdienste zuständig ist. Überall muss Hans-Georg Maaßen erklären, welche Anhaltspunkte er dafür hatte, dass jenes Video aus Chemnitz gefälscht sein sollte als Beleg für eine mögliche Hetzjagd auf Migranten.

Jetzt steht das Internetportal Youtube im Verdacht, gezielt zu rechten und rassistischen Inhalten zu führen. Es heißt sogar, Youtube sei eine gigantische Radikalisierungsmaschine. Das hat natürlich mit dem Algorithmus zu tun, den Youtube benutzt, also fragen wir Matthias Spielkamp von Algorithmwatch, wie das genau funktioniert. Guten Morgen, Herr Spielkamp!

Matthias Spielkamp: Ja, guten Morgen, Frau Welty!

Vorgeschlagene Videos haben großen Einfluss

Welty: Eine neue Analyse ist jetzt durchgeführt worden anhand der Ereignisse von Chemnitz und den rechten Aufmärschen dort. Was hat diese Analyse zutage gefördert, was man vorher so nicht wusste?

Spielkamp: Also, sie hat zumindest systematisch mal gezeigt, dass Menschen, die jetzt zum Beispiel im Moment nach Videos schauen, die was mit Chemnitz zu tun haben, dann anschließend Empfehlungen bekommen zu Videos, die eine starke radikale Tendenz haben. In dem Fall geht es in die rechte Richtung. Das heißt, Leute, die sich da Videos anschauen, die werden auf weitere Videos verwiesen von politischen Aktivisten der rechten Szene, sodass sie diese Videos dann vorgeschlagen bekommen.

Und wenn sie die anschauen, dann bekommen sie weitere solche extremen Videos empfohlen von dem Empfehlungssystem von Youtube, sodass sie sich die dann eben auch noch anschauen können, wenn sie wollen – also das ist ja alles immer freiwillig. Aber es hat schon einen großen Einfluss, welche Videos die Plattform einem dann jeweils vorschlägt.

Videos wie das sog. "Hetzjagd"-Video erfreuen sich auf Youtube großen Interesses. © Deutschlandradio / Twitter / Screenshot

Welty: Warum ist das so besorgniserregend? Sie sagen ja selber, ich muss nicht unbedingt nach radikalen Inhalten suchen und ich muss sie schon gar nicht nutzen.

Spielkamp: Ja, das ist richtig. Und die Plattformen sind aber eben einfach inzwischen sehr, sehr groß geworden, Youtube hat Millionen von Nutzern täglich und die Leute gucken sich auch relativ viele Videos an und das ist einfach diese Tendenz. Das heißt, wenn ich jetzt ein Video mir anschaue und ich bekomme anschließend, sagen wir mal, einen Beitrag aus der ARD vorgeschlagen, ich bekomme einen Beitrag von N24 vorgeschlagen, ich bekomme einen Beitrag von irgendjemandem vorgeschlagen, der sich privat da engagiert mit seinem Youtube-Kanal, dann könnte man sagen, okay, alles in Ordnung, da ist eine große Diversität oder Pluralität von Ansichten, und dann kommt es eben darauf an, wofür die Leute sich entscheiden.

Aber die Tendenz ist eben relativ eindeutig so – also ich kann da auch nur die Ergebnisse zitieren, von denen ich da jetzt gelesen habe, aber es gibt ja viele Beispiele, die vorher schon existiert haben –, die Tendenz ist eben so, dass man radikalisierte Vorschläge bekommt. Das heißt, mit jedem Mal, wenn man so einer Empfehlung folgt, werden die Vorschläge, ich sag es mal einfach, schlimmer – um es ein bisschen zusammenzufassen.

Viel Zuspruch für Verschwörungstheorien

Welty: Wird jemand zum Nazi, weil er oder sie sich ein Nazivideo anschaut?

Spielkamp: Das mit Sicherheit nicht. Darüber wird richtigerweise sehr viel gestritten und da sprechen Sie einen ganz wichtigen Punkt an. Wir können natürlich jetzt nicht einfach annehmen, weil Leute diesen Dingen ausgesetzt sind, weil sie sie anschauen, radikalisieren sie sich. Dieser Zusammenhang ist sehr, sehr schwer herzustellen, vor allen Dingen tatsächlich eine Kausalität, die werden sie da nicht bekommen. Wir sind wahnsinnig vielen Einflüssen ausgesetzt in unserem Leben. Dass aber unser Medienkonsum einen Einfluss hat auf unser ganzes Verhalten und unsere politischen Ansichten, das würde wohl niemand bestreiten. Es ist eben immer schwierig zu sagen, wie wichtig ist denn nun genau dieser Einfluss, der da ausgeübt wird.

Welty: Grundlage für das, was den Usern alles an Inhalten angeboten wird, das ist ja immer ein Algorithmus. Unterscheidet der sich bei Youtube von anderen Plattformen, ist Youtube fieser oder böser oder vielleicht einfach nur besser?

Spielkamp: Ja, es fällt mir schwer, überhaupt einen von diesen Begriffen auszuwählen.

Welty: Dann wählen Sie einen anderen!

Spielkamp: Ja, ja! Fieser mit Sicherheit nicht in dem Sinne, dass bisher jetzt niemand Youtube unterstellt hat, dass da eine wissentliche Manipulation vorliegt, ich selber tue das auch nicht. Es geht nicht darum zu sagen, Youtube möchte, dass die Leute radikale politische Videos sehen, sondern es ist eher die Idee dahinter, dass solche Extremvideos – da kann man auch das Beispiel nehmen von Verschwörungstheorien oder irgendwelchen Leuten, die behaupten, die Erde sei flach –, diese Videos mit extremen Ansichten, die bekommen sehr viel Zuspruch. Und das versteht sozusagen der Algorithmus beziehungsweise die Leute dahinter, die das programmieren.

Bei Youtube sehen Kinder möglicherweise Videos, die nicht für sie geeignet sind.© imago/Thomas Eisenhuth

Und die Plattformen wie Youtube sind darauf ausgelegt, dass die Leute sich da so lange wie möglich aufhalten sollten, die sollen da so viel Zeit wie möglich verbringen. Und deswegen gibt es diese These, dass das radikalisiert, weil diese radikalen Ansichten eben besonders attraktiv sind für viele Menschen. Das versteht das System und schlägt deswegen weiter diese radikalen Ansichten vor. Und da hat natürlich der Anbieter, in dem Fall Google beziehungsweise Youtube, auf jeden Fall eine Mitverantwortung, denn diese Systematik, die dahinter steht, die fällt nicht vom Himmel, sondern darüber entscheiden Menschen, wie das eingesetzt wird. Das heißt, da müssen sie auch schon eine Verantwortung dafür übernehmen.

Eltern sollten ihr Kind nicht allein Youtube schauen lassen

Welty: Das heißt dieses Prinzip der Radikalisierung gilt nicht nur für rechte Inhalte, sondern auch für linke oder pornographische beispielsweise?

Spielkamp: Ja, sicherlich. Ich meine, Sex sells, das wissen wir schon sehr, sehr lange, das heißt, da kann man ja eine gute Analogie ziehen. Da gibt es dann bestimme Angebote, von denen man einfach weiß, dass sie attraktiv sind und dass man Leute damit locken kann. Und jetzt stellt sich eben immer weiter heraus, dass so etwas auch für politisch radikale Ansichten gilt. Ja, Sie haben völlig recht, es geht nicht nur um Rechtsradikalismus, es geht um alle Arten von radikalen Ansichten, die Menschen offenbar einfach so attraktiv finden, dass sie denen gerne zuschauen beziehungsweise dass sie sich diese Inhalte gerne ansehen.

Welty: Verselbstständigen sich solche Systeme oder anders gefragt: Kann Anbietern wie Youtube auch die Kontrolle darüber verloren gehen?

Spielkamp: Ich bin mir da ganz sicher! Wir wissen einfach weiterhin viel zu wenig darüber, wie diese Systeme genau funktionieren, um das so beurteilen zu können, aber es hat im vergangenen Jahr ein sehr interessantes und schockierendes Beispiel gegeben. Da hat ein amerikanischer Journalist und Künstler einen langen Essay geschrieben, nachdem er selber recherchiert hat und geschaut hat, welche Empfehlungen bekommt man denn, wenn man Kindervideos anschaut. Natürlich in dem Sinne, welche Empfehlungen Kinder bekommen, wenn sie Videos bei Youtube anschauen.

Und da war die Tendenz dieselbe, es wurde auf immer abstrusere, zum Teil schockierende Videos verwiesen, sodass, wenn man praktisch ein Kind alleine Youtube schauen lässt und es immer nur den Empfehlungen folgt, am Ende das in so eine Art Abgrund von schlimmen Videos gelangt. Und da kann man schon sagen, da halte ich es für glaubwürdig, so will ich es mal sagen, da halte ich es für glaubwürdig, dass Youtube das selber so nicht wollte, die Leute die hinter Youtube stehen, die haben auch gesagt, wir müssen da was tun und müssen das ändern, und haben an dem Empfehlungssystem geschraubt.

Das ist für mich im Grunde genommen ein… Also einmal natürlich positiv, dass sie darauf reagiert haben, aber es ist auch ein Zugeständnis, dass sie darüber sich nicht im Klaren waren, dass sie nicht wussten, was da passiert ist, und dass sie das einfach haben laufen lassen. Und da sind sie mit Sicherheit ihrer Verantwortung nicht gerecht geworden.

An Symptomen herumdoktern reicht nicht

Welty: Aber diese neue Analyse, die zeigt ja dann auch wieder, dass auch das Daran-Schrauben ja nicht funktioniert hat oder?

Spielkamp: Das weiß ich jetzt nicht so genau, ob es das schon zeigt, da müsste ich vielleicht noch ein paar Informationen haben. Das Schwierige an dem Schrauben mit der Hand ist eben, dass man ja im Grunde genommen so ein bisschen am Symptom rumdoktert, das heißt, wenn das Prinzip jetzt nicht richtig funktioniert, dann funktioniert man die schlimmsten Abweichungen in den Griff zu bekommen, indem man dann eingreift, wenn einer dann darauf hinweist.

Aber da sind Millionen und Abermillionen von Videos auf der Plattform, und das kann man nicht mit der Hand machen, also in dem Sinne, dass man dann immer da, wo irgendetwas Schlimmes passiert, eingreift. Das schauen sich Leute in 190 Ländern auf der Welt an, nach völlig unterschiedlichen kulturellen Vorstellungen und nach dem, was da gut und falsch und richtig und schön ist. Und da muss einfach das System besser drauf eingestellt sein und das System heißt aber in dem Fall auch, dass sich die Leute, die das entwickeln, da mehr Gedanken darüber machen können. Da einfach immer Flickschusterei zu betreiben, das wird auf Dauer nicht funktionieren.

Welty: Habe ich als User eine Möglichkeit, das zu steuern? Dass ich sage, oder dem System irgendwie deutlich machen kann, nein, das ist nicht die Richtung, in der ich suche?

Spielkamp: Also, was natürlich passiert, ist, wenn Sie zum Beispiel eingeloggt sind mit Ihrem Account, dann wird Ihre Nutzung halt relativ gut gespeichert und Ihrem Profil zugeordnet. Und wenn Sie jetzt sagen, das stört mich nicht, das mache ich, dann ist es so, dass Google beziehungsweise Youtube diese Signale natürlich speichert. Das heißt, jedes Mal, wenn Sie so ein Video vorgeschlagen bekommen und sich das dann nicht anschauen, dann merkt sich das das System natürlich – und dann bekommen Sie entsprechende Vorschläge hinterher und dadurch beeinflussen Sie das schon.

Es ist allerdings jetzt auch für sehr schwer zu sagen, wie stark dieser Einfluss ist, das heißt also, wie viele Male müssen Sie zum Beispiel so eine radikale politische Meinung nicht angeklickt haben, damit sie Ihnen nicht wieder vorgeschlagen wird. Das sind genau die Fragen, die wir untersuchen müssen und bei denen wir dann eben auch sagen müssen, Youtube, da müsst ihr wirklich mal ein paar Daten zur Verfügung stellen, damit man das mal von außen analysieren kann.

Welty: Vorsicht bei der Youtube-Suche, womöglich werden Ihnen Videos angeboten, die Sie lieber nicht sehen wollen. Matthias Spielkamp war das von Algorithmwatch. Dankeschön!

Spielkamp: Gerne!

Äußerungen unserer Gesprächspartner geben deren eigene Auffassungen wieder. Deutschlandfunk Kultur macht sich Äußerungen seiner Gesprächspartner in Interviews und Diskussionen nicht zu eigen.