Die Evolution der Maschinen

Von Mike Herbstreuth · 17.12.2015

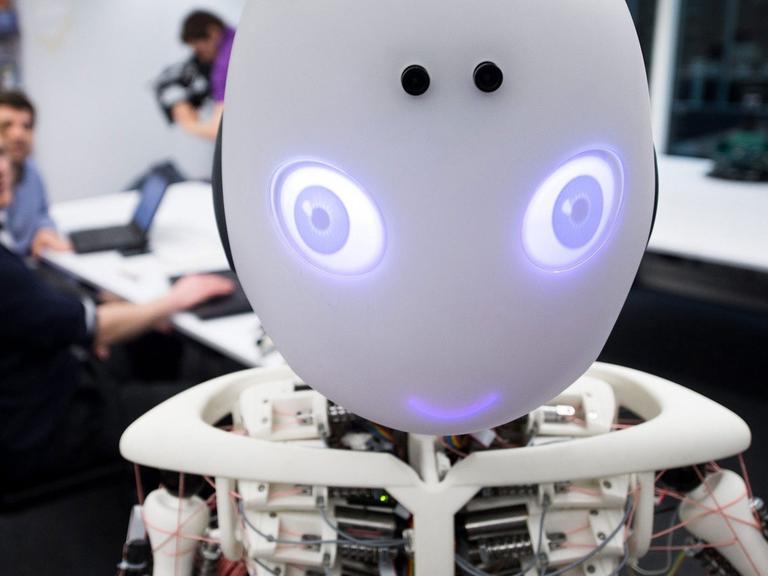

Was in Filmen wie "Ex Machina" oder "2001 - Odyssee im Weltraum" noch unglaublich wirkt, könnte bald schon Realität sein: Maschinen mit künstlicher Intelligenz, die selbstständig lernen und Probleme lösen. Ob dies Fluch oder Segen für die Menschheit ist – darüber herrscht noch Uneinigkeit.

"One day the AIs are going to look back on us the same way we look at fossil skeletons on the plains of Africa."

Nur Relikte einer längst vergangenen Zeit werden wir eines Tages für Maschinen mit künstlicher Intelligenz sein, das prophezeit der exzentrische Tech-Billionär Nathan Bateman im Film "Ex Machina" – er selbst hat gerade den Prototypen für einen Androiden mit künstlicher Intelligenz, kurz KI, entworfen.

Diese Herrschaft der neuen superintelligenten Maschinen wurde schon oft herbei befürchtet. Zum Beispiel 1997. Da standen wir von einer "Menschendämmerung", wie der Rheinische Merkur geschrieben hat – denn gerade hatten wir die "Zitterpartie um die Zukunft der menschlichen Intelligenz" verloren, so die Süddeutsche Zeitung. Der Schachgroßmeister Gari Kasparow war vom IBM-Schachcomputer "Deep Blue" besiegt worden:

"Deep Blue has defeated world champion Gari Kasparow!"

Trotz dieser Niederlage mussten wir uns den Maschinen bislang nicht unterwerfen, für Googles "KI"-Experten Demir Hassabis relativ logisch:

"Deep Blue – whilst amazing at chess, can't do anything else. [...] Deep Blue spielt zwar großartig Schach, kann aber ansonsten nichts Anderes. Daran sieht man ganz gut, dass 'Deep Blue' nicht intelligent ist im Sinne von Intelligenz, wie wir sie verstehen. Zum Beispiel kann 'Deep Blue' nicht einmal ein viel simpleres Spiel wie 'Vier gewinnt' spielen. Nichts in seiner Programmierung hilft ihm bei einem so einfachen Spiel - obwohl der Computer Weltklasse im Schach ist."

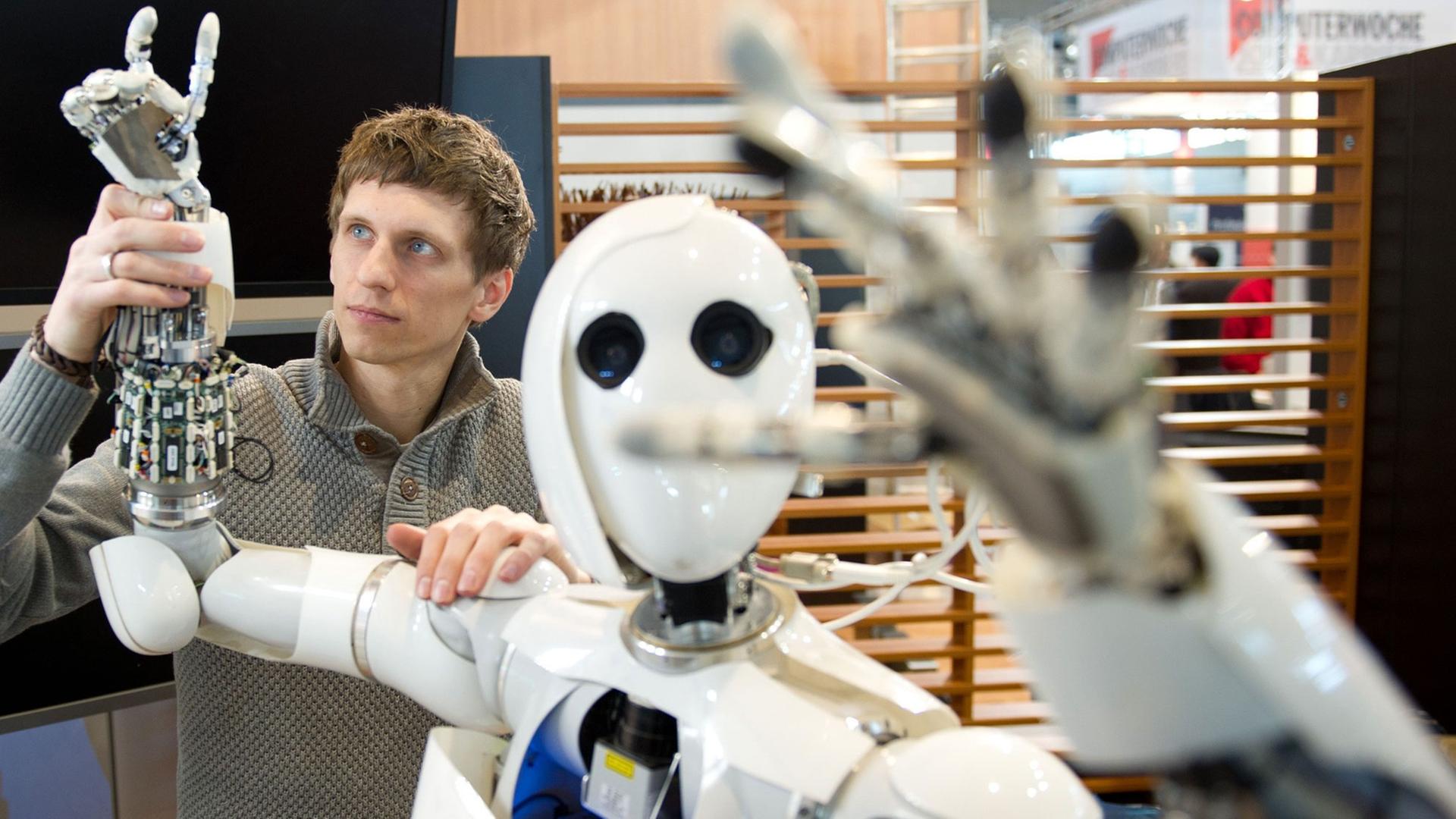

Eine wirklich intelligente Maschine lernt selbstständig

Eine wirklich intelligente Maschine – das wäre für Hassabis ein System, das verschiedenste Probleme lösen kann, ohne für exakt diese Probleme programmiert worden zu sein. Ein System, das selbstständig dazulernen kann. Daran arbeitet Hassabis. "Deep Mind" heißt sein Projekt bei Google, bei dem er und sein Team Alogrithmen entwickeln, die selbständig lernen – über Erfahrung. Eine Praxis, die sich "Deep Learning" nennt und am Gehirn des Menschen orientiert. Je mehr Daten diese KI-Systeme bekommen und je mehr Zeit man ihnen gibt, desto besser werden sie. Getestet werden diese Algorithmen bei Google über simple Atari-Videospiele aus den 80er Jahren. Hassabis:

The AI-System just gets raw pixels as input [...] Das KI-System bekommt als Input Pixel mit dem Ziel, so viele Punkte wie möglich zu machen. Alles Andere wird von Grund auf gelernt, direkt von den Pixeln auf dem Bildschirm."

Das Atari-Computer-Spiel "Breakout" – bei man ähnlich wie bei Pong mit einem Schläger und einem Ball eine Wand aus kleinen Pixel-Steinen zerstören muss – verstand der Algorithmus nach 100 Spielen so langsam. Nach 300 war er so gut wie jeder gewöhnliche Mensch, und noch ein paar hundert Spiele später hatte der Algorithmus die ideale Spiel-Strategie herausgefunden – eine Strategie, die sogar einigen Programmierern nicht eingefallen war. In den nächsten Jahren soll der Algorithmus dann auch 3D-Spiele locker meistern können. Und bald dann irgendwann zur Gefahr für den Menschen werden?

"Wir sind wie ein Kind, das mit einer Bombe spielt"

Es ist die Handlung fast jedes Films über künstliche Intelligenz: Superintelligente Maschinen – also Systeme, die uns Menschen intellektuell überlegen sind, und die durch ihre eigene Intelligenz die Möglichkeit haben, sich selbst immer intelligenter und überlegender zu machen – haben irgendwann genug von uns und löschen die Menschheit aus.

Das klingt nach Science-Fiction, nur: Existiert künstliche, lernende Superintelligenz erst einmal, gibt es kaum eine Möglichkeit für uns, sie zu bändigen.

Der schwedische Technik-Philosoph Nick Bostrom formuliert es so: "Wir sind wie ein Kind, das mit einer Bombe spielt. Die Macht künstlicher Superintelligenz steht in komplettem Missverhältnis zu unserer eigenen Reife". Es ist eine unfassbare Verantwortung. Superintelligente KI könnte alle Probleme der Menschheit lösen – oder unser größtes Problem werden. Der Schlüssel zu ewigem, gutem Leben sein, oder die Bombe, mit der wir leichtsinnigerweise herumspielen.

Vor den Gefahren zu intelligenter Maschinen haben dieses Jahr auch über tausend Experten in einem offenen Brief gewarnt, darunter Stephen Hawking und Tesla-Gründer Elon Musk: "Unsere KI-Systeme müssen das tun, was wir wollen", so der Tenor des Briefs. Dabei sind die Forscher Künstlicher Intelligenz überhaupt nicht abgeneigt: "Erfolge in der Suche nach künstlicher Intelligenz haben das Potenzial, noch nie dagewesene Vorteile für die Menschen zu bringen", heißt es in dem Brief. Mit dem Zusatz: "Wie diese Vorteile maximiert werden können, während man mögliche Fallstricke vermeidet."

Ein paar Jahrzehnte bis zur superintelligenten Maschine

Eine Meinung, die auch Demir Hassabis vertritt. Sein Traum: Mit Hilfe von superintelligenten Maschinen die Probleme lösen, die zu komplex geworden sind für die Forschung: Krankheiten heilen, Armut und Hunger besiegen, Teilchenphysik verstehen. Aber:

"As with all technologies [...] Genau wie alle anderen Technologien muss Künstliche Intelligenz ethisch und verantwortungsvoll eingesetzt werden. Obwohl KI, die mit Menschen mithalten kann, noch Jahrzehnte entfernt ist, müssen wir schon jetzt mit der Diskussion darüber beginnen."

Ein paar Jahrzehnte bis zur superintelligenten Maschine – unter Forschern eine sehr wahrscheinliche Schätzung. Zwei Studien, in denen insgesamt mehrere hundert KI-Experten befragt wurden, wann es den ersten superintelligenten Computer geben könnte, haben im Schnitt ergeben: 2060 ist es spätestens so weit. Dann könnte sich entscheiden: Schlüssel oder Bombe.

Was allerdings ganz sicher ist. Kommen wird die künstliche Intelligenz. Oder wie es Nathan Bateman im Film "Ex Machina" ausdrückt:

"The variable is when, not if."